Ist die CTR nun ein Rankingfaktor, oder nicht? Und wenn ja, ist sie ein direkter oder ein indirekter Rankingfaktor?

Fragen, die nicht nur ich mir stelle. Viele haben bereits darüber geschrieben, aber eine klare Antwort konnten sie nie liefern und denjenigen, die es können, nämlich Google, wird zum Teil Glauben geschenkt, zum Teil aber auch nicht.

OMT-Podcast mit Kai Spriestersbach, Mario Jung

Diskussion CTR: Rankingfaktor ja oder nein – OMT-Podcast Folge #023

Ich kann an dieser Stelle vorgreifen, dass auch ich keine klare Aussagen treffen kann und auch nicht treffen werde. Ich werde Fakten und Daten zusammentragen und meine persönliche Meinung und Ansicht dazu äußern.

Google-Mitarbeiter Gary Illyes dementiert auf Reddit, dass die Verweilzeit und CTR als Rankingfaktor genutzt werden. Damit hätten wir unsere Aussage und der Artikel wäre an dieser Stelle beendet. Jetzt wird, wie bereits erwähnt, diesen Aussagen nicht immer Glauben geschenkt und behauptet, es sei an den Rankingfaktoren doch etwas dran, wenn dies seitens Google so aktiv dementiert wird.

„Dwell time, CTR, whatever Fishkin's new theory is, those are generally made-up crap. Search is much more simple than people think.”

Immer wieder werden Tests gemacht, die etwas aufdecken sollen, aber es wird nie geschafft, ein 100 % klares Ergebnis zu liefern. Zu viele Faktoren spielen in der Suche eine Rolle und da Google zu blickdicht ist, kennt niemand die Faktoren bzw. den genauen Algorithmus, angeblich selbst Google nicht.

Wie soll also ein Test einer externen Person ein zufriedenstellendes Ergebnis liefern?

Verschiedene Personen, darunter Rand Fishkin, der bereits im Zitat von Gary Illyes erwähnt wird, haben Tests gemacht, um den angeblichen Rankingfaktor von Verweilzeit und CTR zu beweisen.

Test zur CTR und Pogosticking von Rand Fishkin

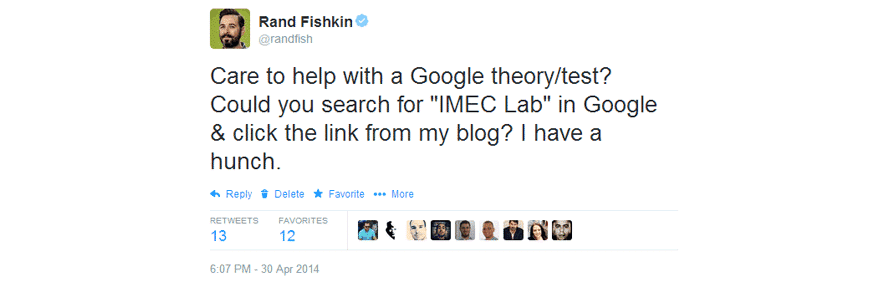

Rand Fishkin hat 2014 einen Artikel veröffentlicht, in dem er über einen Test bezüglich der CTR als Rankingfaktor berichtete.

Rand hatte einen Blogbeitrag zu dem Thema „IMEC Lab“ geschrieben und auf seinem eigenen Blog veröffentlicht. Eine Woche später belegte der Blogartikel bei der Suchanfrage „IMEC Lab“ Position 7 in den Google Suchergebnissen der USA.

Rand Fishkin hatte zuvor mit einigen Branchenkollegen mehrere Beobachtungen gemacht und wollte anhand dieses Blogartikels die Beobachtungen nachstellen. Er setzte daher einen Post bei Twitter ab, in dem er dazu aufrief, bei Google nach „IMEC Lab“ zu suchen und auf das Suchergebnis von seinem Blog zu klicken.

Quelle: https://sparktoro.com/blog/queries-clicks-influence-googles-results/

Rand Fishkin vermutete, dass zwischen 175 und 250 Menschen den Tweet gesehen und entsprechend seinem Aufruf gefolgt waren, da er laut Google Analytics an dem Tag 228 Besucher über Google hatte und es am Vortag nur 7 Zugriffe gewesen waren.

Drei Stunden nach seinem Tweet, um 21 Uhr, belegte sein Artikel bei der Suchanfrage „IMEC Lab“ plötzlich Position 1 in den US-Ergebnissen. Rand selbst rief das Ergebnis über ein inkognito-Fenster seines Browsers auf, damit Google keine personalisierten Daten einbeziehen konnte. Nutzer bei Twitter berichteten über die gleichen Ergebnisse.

Rand prüfte die Suchergebnisse auch in anderen Ländern, allerdings belegte sein Blogartikel in keinem der 7 geprüften Länder nochmal eine Position unter den Top 5, geschweige denn Position 1. Seine Vermutung für dieses Ergebnis war, dass die Mehrheit der Suchanfragen und Klicks aus den USA stammten und daher lediglich in dieser geografischen Lage eine Veränderung am Ranking stattgefunden hatte.

Er erwähnte in seinem Test, dass die Daten selbstverständlich nicht für einen aussagekräftigen Beweis reichten.

In einer Live Q&A Session mit Google von 2016, welche auf YouTube noch zu sehen ist, sagte Rand Fishkin (ab Minute 14:03), er hätte in den letzten zwei Jahren immer wieder Tests durchgeführt. Wenn er auf der Bühne vor 500 bis 1000 Leuten stand, hat er diese darum gebeten, mit ihrem Smartphone oder Laptop eine vorgegebene Suche bei Google durchzuführen und das siebte Ergebnis anzuklicken.

Sie sehen gerade einen Platzhalterinhalt von YouTube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr InformationenIn sieben oder acht Fällen hat sich die Reihenfolge im Ranking innerhalb von 24 Stunden geändert, in 4 bis 5 Fällen hat keine Änderung in den Suchergebnissen stattgefunden. Die Änderungen hielten zwei bis drei Tage und fielen dann schnell wieder ab.

Andrey Lipattsev, Search Quality Senior Strategist bei Google, antwortete, dass es schwer zu beurteilen sei, wie dies zustande kommt, ohne die genauen Daten zu betrachten. Er vermutet, dass durch das allgemeine Interesse für dieses Thema über Erwähnungen und Links in, aber auch außerhalb sozialer Netzwerke, Signale erzeugt werden, nach denen Google Ausschau hält.

Kai Spriestersbach, Inhaber von Search One, hat in einem Artikel von ähnlichen Tests mit ähnlichen Ergebnissen berichtet, wie sie Rand Fishkin gemacht hatte. Kai hat in seinen Seminaren die Teilnehmer immer wieder darum gebeten, mit ihren Smartphones über die mobilen Daten eine vorgegebene Suche durchzuführen und ein weiter unten platziertes Suchergebnis anzuklicken.

Die Auswirkungen auf die Ranking-Veränderungen waren mal stärker und mal schwächer und auch die Dauer der Veränderung variierte, aber er konnte die Beobachtungen von Rand Fishkin bestätigen.

Die CTR mit Bots beeinflussen

Mit den Erkenntnissen aus den Experimenten von Rand Fishkin kamen schnell die ersten Versuche auf, die CTR automatisch über Bots zu beeinflussen und somit die Rankings zu verändern.

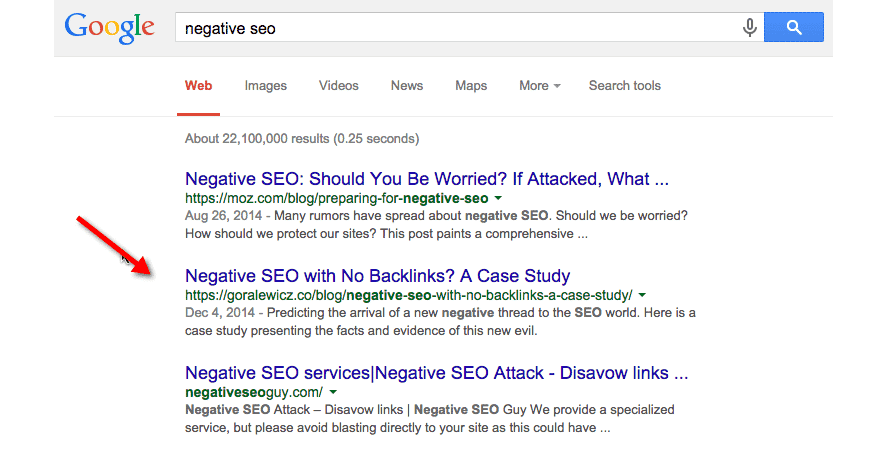

Experiment von Bartosz Góralewicz

Bartosz Góralewicz war Mitwirkender in einem 2015 durchgeführten Experiment, in dem versucht wurde, die Suchergebnisse mit Hilfe von Bots über die CTR zu beeinflussen.

Die Idee hinter dem Experiment war, die Google-Rankings zu manipulieren, also die Position einer Webseite zu verbessern, indem die Klickrate deutlich erhöht, also verbessert wird.

„höhere Klickrate = höhere Position in Google”

Damit dies zweifelsfrei bewiesen werden konnte, setzte sich Góralewicz das Ziel, die Klickrate von allen anderen Ranking-Faktoren zu isolieren, um so den tatsächlichen Einfluss des Suchmaschinen-Rankings zu messen. Das Experiment von Rand Fishkin war in seinen Augen zwar interessant, brachte aber zu viele Möglichkeiten mit, die ebenfalls das Ranking hätten beeinflussen können. Beispielsweise Chrome-Daten, Plug-in-Daten, soziale Medien, Backlinks usw., weshalb die Rankingveränderungen nicht ohne Weiteres nur der Klickrate zugeschrieben werden können.

Bartosz Góralewicz wollte den „menschlichen Faktor“ in seinem Experiment ausschließen.

Der Content für Góralewicz‘s Experiment

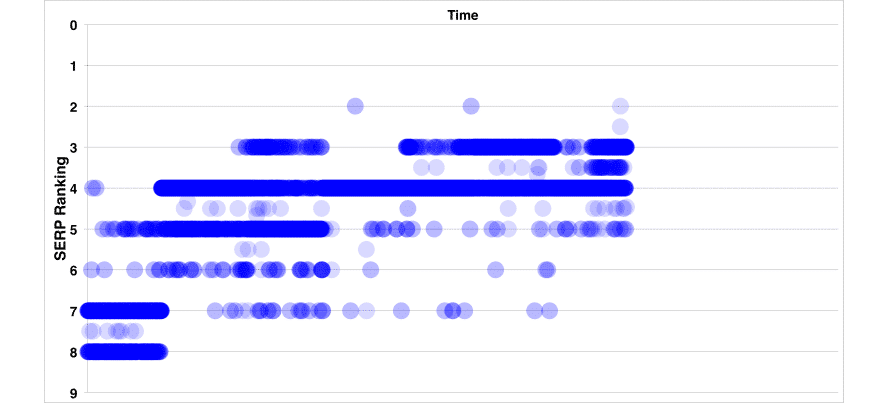

Den Content, der für dieses Experiment gewählt wurde, war ein älterer Artikel von Bartosz Góralewicz selbst zu dem Thema, „Negative SEO“. Dieser Artikel erreiche laut Góralewicz in der Vergangenheit eine Platzierung zwischen Position 2 und 4.

Quelle: https://searchengineland.com/ctr-ranking-factor-227162

Um das Experiment präziser zu machen, wurden von ihm noch weitere Keywords hinzugefügt, deren Rankingentwicklung beobachtet werden konnte.

Die Durchführung des Experiments

Bartosz Góralewicz hatte bereits Erfahrung beim Einsatz von Bots, da er in seinem Experiment „Negative SEO“ damit gearbeitet hatte. Bei dem damals verwendeten Bot-Setup wurden allerdings 60-70 % des Traffics von Google Analytics und der Google Search Console herausgefiltert.

Da in diesem Experiment die Verkehrsdaten von Google beeinflusst werden sollten, war hier der Anspruch, dass sich die Daten auch auf Google Trends und den Google Keyword Planner auswirken.

Nach der Feinabstimmung des Setups begann Góralewicz die Bots auf seine eigene Domain, damals noch „https://goralewicz.co“, zu senden. Die Bots gingen über Google, gaben eine Suchanfrage ein, suchten in den SERPs die entsprechende Domain und klickten auf das Suchergebnis. Anschließend blieben sie 2-4 Minuten auf der Seite und besuchten zufällige Seiten der Domain.

Bartosz Góralewicz hat es mit seinem Setup geschafft, dass die Bots von Google nicht erkannt wurden und die Daten in die unterschiedlichen Analysetools von Google eingelaufen sind.

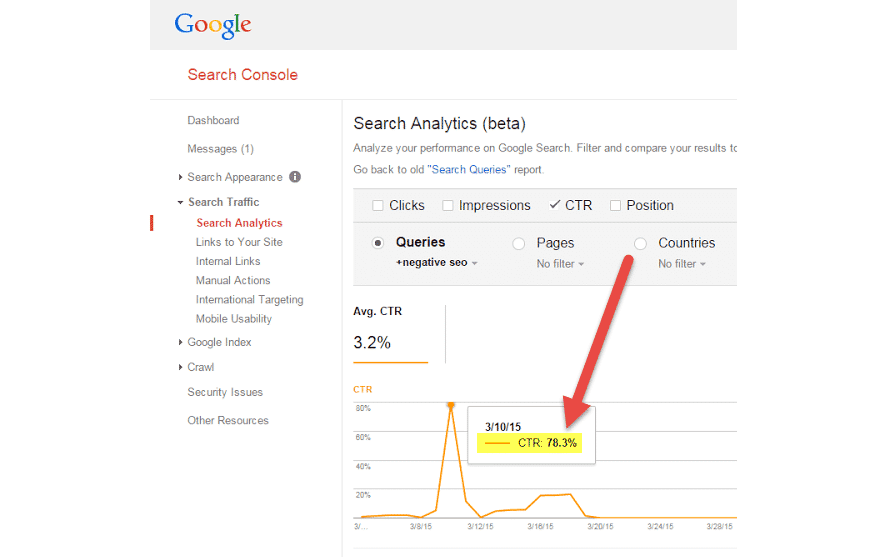

CTR-Veränderungen in der Google Search Console:

Quelle: https://searchengineland.com/ctr-ranking-factor-227162

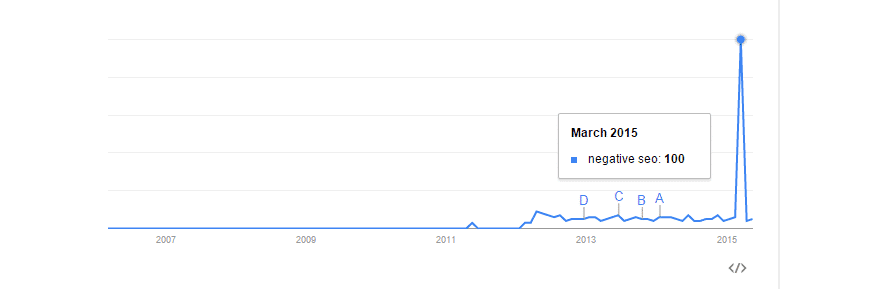

Trend-Veränderung bei Google Trends bei dem Keyword „negative seo“:

Quelle: https://searchengineland.com/ctr-ranking-factor-227162

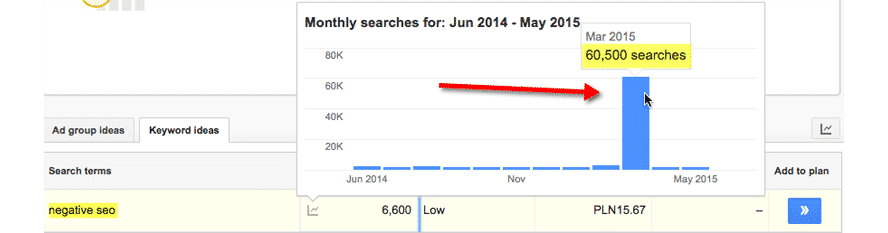

Traffic-Steigerung bei dem Keyword „negative seo“ in Google Ads:

Quelle: https://searchengineland.com/ctr-ranking-factor-227162

Das Ergebnis des Experiments von Bartosz Góralewicz

Mit dem Experiment wurde zwar erreicht, dass die Werte in den hauseigenen Analysetools von Google angestiegen waren, allerdings hat sich keine Rankingveränderung ergeben. Der Artikel belegte vor und auch nach dem Test jeweils Position 2 in den Suchergebnissen von Google.

Die Schlussfolgerung von Góralewicz war damit, dass die Klickrate keinen Einfluss auf die Suchmaschine hat. In seinen Augen ist dies positiv, da es eine große Sicherheitslücke im Google Ranking dargestellt hätte.

Das Experiment von Cesarino Morellato und Andrea Scarpetta

Ebenfalls im Jahr 2015 führten Cesarino Morellato und Andrea Scarpetta ein Experiment durch, in welchem sie Bots nutzen, um die CRT zu beeinflussen und somit das Ranking einer URL in den Google Suchergebnissen zu verbessern.

Cesarino Morellato hatte 2014 von einem Kunden eine umfangreiche Aufgabe übernommen. Er konnte mit Hilfe seiner SEO-Maßnahmen und Linkbuilding-Strategie die meisten konkurrierenden Webseiten in den SERPs hinter sich lassen. Nur zwei veraltete Artikel aus den Jahren 2005-2006 belegten die ersten beiden Plätze und machten ihm Probleme.

Da Morellato trotz seiner Maßnahmen sein Ziel nicht erreichen konnte, entschloss er sich, die Theorie zu testen, dass sich die Klickrate auf die Suchergebnisse auswirkt. Er stellte Mitarbeiter von einem Mikrojob-Netzwerk ein und teilte ihnen die Aufgabe zu, gezielte Suchen durchzuführen und auf das Ergebnis seines Kunden zu klicken.

Innerhalb weniger Wochen hatten sich die Positionen in den SERP getauscht, woraufhin er ein Experiment mit Andrea Scarpetta durchführen wollte, um die Hypothese der Klickrate als Rankingsignal zu bestätigen.

Der Aufbau des Experiments von Morellato und Scarpetta

Morellato und Scarpetta haben eine Software entwickelt, womit die zufällige Abfolge von Klicks bei einer gezielten Suchanfrage simuliert werden kann.

Sie haben rund 500 Zeichenfolgen von User-Agents zwischen Desktop-, Mobile- und Tablet-Browsern gesammelt, die nach dem Zufallsprinzip gesammelt werden, um verschiedene Browser zu simulieren. Zusätzlich hatten sie über einen Proxy-Server Zugriff auf etliche IP-Adressen aus den USA.

Die Software hat bei Google eine gezielte Suchanfrage gestellt, auf die gewünschte URL geklickt und für etwa 20 Sekunden eine Sitzung simuliert.

In 95 % der Fälle hatte die Sitzung eine eindeutige IP-Adresse und die wiederholten IP-Adressen folgten niemals aufeinander. Die Anzahl der Anfragen wurde auch per Zufall bestimmt und lag zwischen 250 und 700 Anfragen pro Tag.

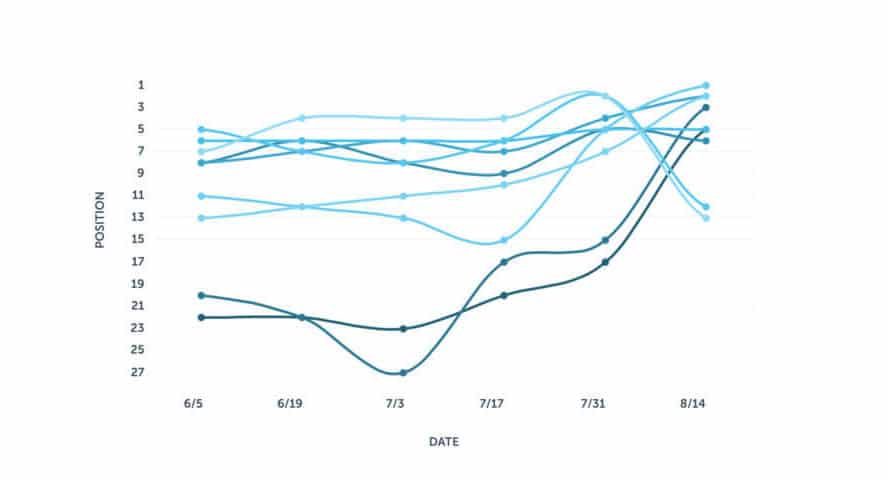

Als Webseite für das Experiment wurde eine veraltete URL über die Olympischen Winterspiele 2002 gewählt, welche fast keine eingehenden Links besitzt und zwischen Position 8 und 10 rankt.

Um die Rankings zu überwachen, wurde sich für Proranktracker.com entschieden.

Ergebnis von Morellato und Scarpetta

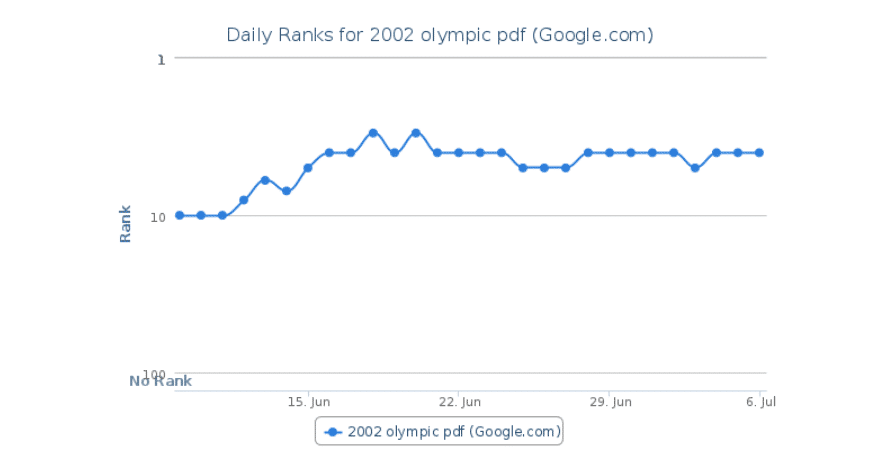

Nachdem der Test eine Woche gelaufen war, konnten die ersten Verbesserungen von Position 10 auf 3 der geklickten URLs verzeichnet werden. Für den Rest des Experiments konnte ein durchschnittlicher Rank von Position 4 und 5 gehalten werden.

Quelle: https://searchengineland.com/yes-click-rate-ranking-signal-225873

Da sich die Ergebnisse der Google-Suche je nach Standort und Nutzer ändern, haben Morellato und Scarpetta zusätzlich zu dem analysierten Ergebnis über Proranktracker.com über die programmierte Software geschaut, auf welcher Position bei Google der Klick des Bots stattgefunden hat.

Den beiden ist dadurch aufgefallen, dass sich die Position häufiger und deutlicher verschoben hat, als bis dahin angenommen.

Quelle: https://searchengineland.com/yes-click-rate-ranking-signal-225873

Morellato und Scarpetta könnten daher nicht klar sagen, ob die Klickrate ein Rankingfaktor ist. Sie können auch nicht sagen, wie lange die Rankingveränderung, die auf diese Weise hervorgerufen wird, bestehen bleibt und ob sich das Ranking anschließend vielleicht sogar verschlechtert. Sie können allerdings bestätigen, dass ein interessanter Title und eine gute Meta-Description, welche die Klickrate beeinflussen, die Rankingfolge sichtbar verändern.

Die Klickrate und somit das Ranking mit Menschen beeinflussen

Brian Patterson war angefixt von den Experimenten und Fallstudien und wollte sich 2016 daher selbst mit einem Test überzeugen. Er besitzt eine Reihe von Test-Websites, um sich von Dingen wie diesen selbst ein Bild machen zu können. Für den CTR-Test hat er eine alte Test-Seite gewählt, welche schon lange nicht mehr überarbeitet und eher vernachlässigt worden war. Die Seite war perfekt, da Rankingveränderungen somit zu 100 % dem Test zugeschrieben werden konnten.

Die Keywords und Klicks für den Test

Patterson hat sich für den Test auf 9 Keyword-Phrasen aus dem Bereich E-Commerce-Produktkategorie festgelegt, die beim Start des Experiments zwischen den Positionen 5 und 25 lagen. Die Reihenfolge der Rankingergebnisse auf den verschiedenen Keywords hatte sich über einen längeren Zeitraum davor so gut wie nicht verändert.

Das Suchvolumen der Keywords lag bei über 50 Suchanfragen pro Monat und der Wettbewerb wurde mit gering bis mittel eingestuft.

Um mehr Klicks zu generieren, hat Patterson Mikrojobber engagiert und diese damit beauftragt, vordefinierte Suchen bei Google durchzuführen. Jeden Tag hat eine zufällige Anzahl an Personen, basierend auf dem tatsächlichen Suchvolumen, das entsprechende Keyword gesucht und auf den vorgegebenen Link geklickt.

Auf der Webseite selbst wurden die Mikrojobber angehalten, zwei Minuten auf der Webseite zu surfen und den Inhalt zu lesen. Das Ziel von Patterson war, die „Besucher“ wie echte Nutzer aussehen zu lassen, die sich für den Content interessieren und nicht nur die CTR nach oben treiben.

Die Schlüsse von Brian Patterson

Brian Patterson hat über den Zeitraum des zweimonatigen Experiments die Rankingveränderungen der 9 Suchbegriffe getrackt. Im Laufe des Tests haben sich alle Keywords verbessert. Sieben von neun Keywords haben das Experiment auch mit einer besseren Rangfolge beendet als zu Beginn des Tests.

Quelle: https://searchengineland.com/test-shows-click-rate-appears-ranking-signal-257527

Daraus hat Patterson, in Verbindung mit anderen Artikeln und Recherchen zu diesem Thema, abgeleitet, dass die Klickrate das Ranking beeinflusst.

Brian Patterson hat in seinen Augen belegt, wie wichtig die Optimierung von Meta-Title und Meta-Description ist, um höhere Klicks zu erzielen. Außerdem erwähnt er, dass der Content auf der Webseite den Nutzer fesseln muss, schließlich haben sich die Mikrojobber wie „echte Nutzer“ verhalten und waren mindestens 2 Minuten auf der Webseite aktiv. Dies muss bei wirklichen Nutzern ebenfalls gelingen, da es sich eventuell negativ auswirkt, sollten die Besucher wegen des schlechten Contents unbeabsichtigt Pogosticking betreiben.

Zwischenfazit

Wir haben nun die Experimente von Rand Fishkin, Cesarino Morellato und Andrea Scarpetta, Bartosz Góralewicz und Brian Patterson betrachtet. Alle vier Experimente hatten unterschiedliche Ansätze und Vorgehensweisen. Trotzdem können die Experimente in Gruppen geclustert werden.

Rand Fishkin und Brian Patterson haben in ihrem Experiment jeweils dafür gesorgt, dass Menschen die Suche bei Google ausführen, ein vorgegebenes Suchergebnis anklicken und mit dem bewussten Surfen auf der entsprechend Webseite der Suchmaschine ihr Interesse vorspielten.

Damit konnten beide deutliche Veränderungen in den Suchergebissen verzeichnen. Rand Fishkin rechnete dies schnell der Klickrate zu. Patterson war dort etwas defensiver und sprach den Erfolg nicht deutlich der CTR zu.

Cesarino Morellato und Andrea Scarpetta, sowie Bartosz Góralewicz versuchten mit Hilfe von Bots die CTR und somit das Ranking in den Suchergebnissen von Google zu beeinflussen. Bartosz Góralewicz schickte Übermengen an Bots los, um sein Suchergebnis zu pushen. Seine Bots waren so gut eingerichtet, dass diese als „Nutzer“ in sämtlichen Google-Tools aufliefen. Wichtig für den Test war Góralewicz auch, „Stördaten“ wie Informationen von Browsern oder Endgeräten nicht mit einzubeziehen, um ausschließlich die Klickrate zu testen.

Cesarino Morellato und Andrea Scarpetta haben in ihren Test bewusst Informationen über Endgerät und verwendeten Browser einfließen lassen. Außerdem haben sie die Anfragen der Bots entsprechend dem Suchvolumen angepasst, um eine „natürliche“ CTR zu simulieren.

Bartosz Góralewicz hatte mit seinem Experiment keinen Erfolg und damit in seinen Augen bewiesen, dass die CTR kein Rankingfaktor ist. Morellato und Scarpetta hatten Erfolg und konnten eine Veränderung der Rankings verursachen. Durch die starken Schwankungen und Unterschiede zwischen den Standorten konnten sie allerdings keine klare Aussage treffen, ob die CTR ein Rankingfaktor ist oder nicht.

Was sagen Experten aus der Branche

Eric Enge zu dem Thema „Warum ist die Klickrate ein Ranking-Faktor?“

Auf die Frage, ob Google die Klickrate als direkten Ranking-Faktor verwendet, antwortet Eric Enge in seinem Blogartikel von 2016 mit „nein“. Seiner Meinung nach nutzt Google die Klickrate hauptsächlich zur Qualitätskontrolle neuer Algorithmen und eventuell von Zeit zu Zeit, um die Sachqualität zu überprüfen. Google bewertet damit die Zufriedenheit und Nutzerinteraktion in den eigenen Suchergebnissen und verwendet die Daten, um Entscheidungen über weitere Optimierungen treffen zu können.

Eric Enge hat das Experiment von Rand Fishkin betrachtet und ist der Ansicht, dass bei Fishkins Tests ausschließlich eine Rankingverbesserung stattgefunden hat, weil Google die Klickrate auch zur Ermittlung von Trendthemen verwendet.

„CTR in the search results isn’t a direct ranking factor because it’s too easy a signal to game, and in many other cases too hard a signal to use effectively.”

Die Klickrate wäre ein viel zu einfaches Signal, um als direkter Rankingfaktor verwendet zu werden. Menschen würden Bots implementieren oder anderen Menschen für die Manipulation der CTR bezahlen.

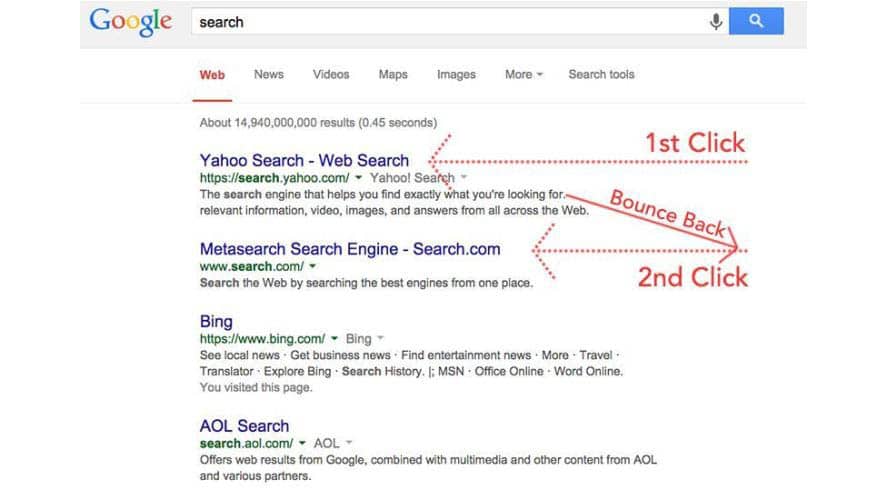

Auch die Theorie des ausgefeilten Konzeptes namens „Pogosticking“ ist in den Augen von Eric Enge nur ein Mythos. Das „natürliche“ Verhalten eines Nutzers in den Suchergebnissen bringt schließlich mit sich, dass der User zu den SERPs zurückkehrt und ein anderes Ergebnis anklickt.

Für die erste angeklickte Webseite soll dies negativ sein, da der User vermittelt, mit dem Content von der ersten Webseite unzufrieden gewesen zu sein. Wie ist es allerdings, wenn er einen Teil der Antwort auf der ersten und den Rest auf der zweiten Webseite findet?

Bei einem Preisvergleich ist es ähnlich. Hier war der User mit den Produkten und den Angeboten auf Webseite 1 zufrieden und hätte kaufen können, wollte aber prüfen, ob es das gewünschte Produkt günstiger gibt.

Quelle: https://blogs.perficientdigital.com/2016/04/27/why-ctr-isnt-a-ranking-factor/

Eric Enge hält daher, wie einleitend erwähnt, daran fest, dass die Klickrate kein direkter Rankingfaktor ist und der Google-Algorithmus darauf ausgelegt ist, aktuelle Nachrichtenereignisse aufzuzeigen, wodurch die Beobachtungen in Fishkins Experiment ausgelöst wurden. Dies erklärt nämlich nicht nur den Anstieg, sondern auch den Abfall danach, als die Klickaktivität nachließ.

Barry Schwartz zu dem Thema „Google verwendet keine Klickrate für Core-Search-Rankings“

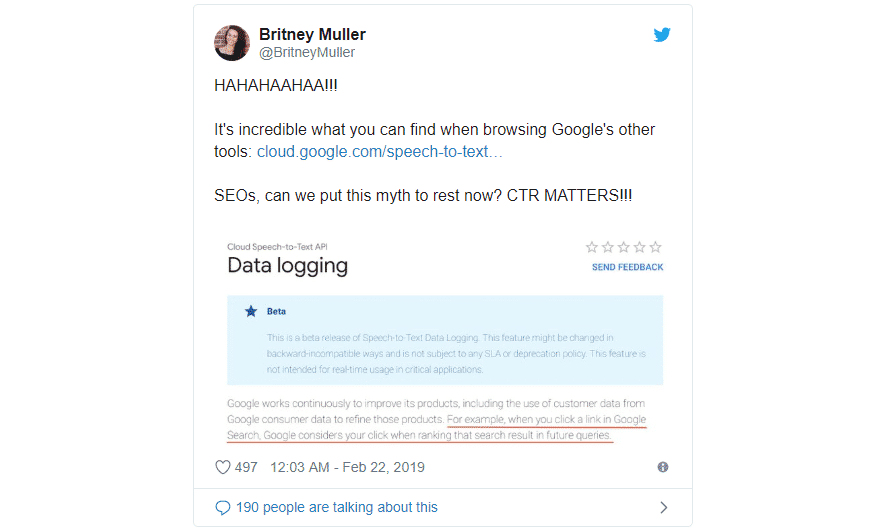

Barry Schwartz hat im Februar 2019 einen Artikel veröffentlicht, in dem er neueste Vermutungen und Aussagen von Google zusammentrug. Er selbst glaubt nicht an die Theorie, dass Google die Klickrate als Rankingfaktor verwendet und ist es leid, seit Dutzenden von Jahren dieses Thema immer wieder zu behandeln.

In seinem Artikel erwähnt er einen Tweet von Britney Muller von Moz. Britney hatte einen Ausschnitt einer Google Entwicklerseite gepostet, auf welcher Folgendes geschrieben steht: „Wenn Sie zum Beispiel in der Google-Suche auf einen Link klicken, berücksichtigt Google diesen Klick für das Ranking dieses Suchergebnisses bei zukünftigen Suchanfragen.“

Britney Muller liefert dies als Beweis dafür, dass Google die CTR verwendet, um die Rankings in den Suchergebnissen festzulegen und somit die Klickrate die Rankings beeinflusst.

Quelle: https://www.seroundtable.com/google-ctr-search-rankings-27157.html

Barry Schwartz bezieht sich auf die Aussage von Gary Illyes, der die Theorie über die Verweildauer, CTR und anderer Nutzersignale als Rankingfaktor als allgemeinen Mist ansieht.

Schwartz beruft sich außerdem auf einen Blogbeitrag von 2009 seitens Google, in dem sie erklären, wie die Suchergebnisse personalisiert werden. Die Klicks beeinflussen die Suche, allerdings nur die eigenen Suchergebnisse und die globalen. Google verwendet somit die vorherigen Abfragen, um die Suchergebnisse für jeden individuell anzupassen.

„Da ich zum Beispiel immer nach 'Rezepten' suche und häufig auf Ergebnisse von epicurious.com klicke, könnte Google epicurious.com auf der Ergebnisseite höher einstufen, wenn ich das nächste Mal nach Rezepten suche. Ein anderes Mal, wenn ich nach Neuigkeiten über die Sportmannschaften der Cornell University suche, suche ich nach 'big red'. Da ich häufig auf www.cornellbigred.com klicke, zeigt mir Google dieses Ergebnis möglicherweise zuerst anstelle der Big Red Soda Company oder anderer.”

Googles CTR-Antwort

Der Tweet von Britney Muller ließ Barry Schwartz nicht los und so bat er Google um eine Erklärung bezüglich der Klickrate, die er veröffentlichen könne. In dem Blog von Search Engine Land veröffentlichte Barry die Aussage von Google.

„Wie wir bereits erwähnt haben, verwenden wir Interaktionen auf verschiedene Weise, beispielsweise für Personalisierungs-, Evaluierungszwecke und Trainingsdaten. Wir haben hier nichts Neues oder Weiteres zu teilen als das, was wir schon lange gesagt haben: Großartige, ansprechende Inhalte sind der richtige Weg zum Erfolg. Wir möchten Websitebesitzer dazu ermutigen, sich auf dieses große Ganze zu konzentrieren”

Seit über 10 Jahren hat Google immer wieder mitgeteilt, sie würden keine Nutzersignale für die Rangfolge verwenden und Gary Illyes hat dies mit seiner Aussage nochmal deutlich bestätigt.

In den letzten Jahren haben SEOs immer wieder neue Studien veröffentlicht, die diese Aussagen von Google widerlegen sollen, woraufhin Google auf Rückfrage mit der obenstehenden Antwort reagiert.

In den Augen von Barry Schwartz verwirrt diese Aussage die Dinge noch mehr, da Google keine klare Stellung bezieht. Trotz der schwammigen Aussage von Google ist Barry der Meinung, dass die Nutzersignale nicht in die Rankings einfließen und wenn doch, verfügen sie über Systeme, um die Manipulation von Klicks zu erkennen.

Fazit

Ist die CTR nun ein Rankingfaktor oder nicht?

Wie eingangs bereits geschrieben, kann ich diese Frage nicht beantworten, auch nicht am Ende dieses Artikels, da die Tests auf der einen Seite zu unterschiedliche Erkenntnisse geliefert haben und wir auf der anderen Seite nicht wissen, welche Faktoren von Google außerdem berücksichtigt werden.

Ich denke, dass alle Experten auf eine gewisse Art und Weise recht haben und ich denke, dass die Nutzersignale die Rankings bei Google beeinflussen. Wie stark oder schwach die Einflüsse sind, ist schwer zu sagen, da die oben genannten Experimente zu unterschiedliche Ergebnisse geliefert haben.

Es konnte klar gesagt werden, dass die CTR alleine kein Rankingfaktor ist, da Bartosz Góralewicz dies mit seinen Bots bewiesen hat. Mich stört an diesem Experiment allerdings die hohe Anzahl an Bots, die Góralewicz an Google geschickt hat. Die Daten sind zwar in den Google Tools eingelaufen, trotzdem sind die Massen an Bots für mich ein Dorn im Auge, weshalb ich bei diesem Experiment den größten Zwiespalt habe, ob ich mich auf das Ergebnis einlasse oder nicht.

Rand Fishkin, Brian Patterson und auch Kai Spriestersbach haben mit ihren User-Experimenten in meinen Augen bewiesen, dass Nutzersignale das Ranking bei Google beeinflussen können. Was bei ihren Tests nicht gesagt werden kann, ist, welches Usersignal die Rankingveränderung hervorruft. Ich vermute, dass alle zu einem gewissen Teil etwas dazu beitragen.

Dies haben Cesarino Morellato und Andrea Scarpetta für mich gut dargestellt, da sie mit ihren Bots auch Daten übermittelt haben, die auch ein Nutzer mitbringen würde, außerdem haben sie sich an realistischen Suchvolumen orientiert.

Die Nutzerzahlen auf einer Seite künstlich zu erhöhen und positive Nutzersignale zu übermitteln, bringt in meinen Augen nichts. Die Rankings rutschen, wie in den Experimenten gezeigt, wieder ab, sobald Traffic und Nutzersignale schlechter werden. Dauerhaft die Daten zu manipulieren, ist eventuell eine Möglichkeit, bringt dem Erfolg der Webseite aber trotzdem nichts, da die Webseite nicht das beste Ergebnis für die gestellte Suchanfrage ist.

Der Traffic auf Position 1 wird zwar zunehmen, aber auch die negativen Nutzersignale, da die echten User mit der Qualität der Webseite nicht glücklich sind.

Sie sehen gerade einen Platzhalterinhalt von YouTube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr Informationen

Apple Podcasts

Apple Podcasts