Im Vortrag werden 12 Analysemöglichkeiten für ein Website Audit mit Screaming Frog gezeigt. Im Fokus stehen dabei die Funktionen Custom Search, Custom Extraction sowie die API Anbindungen an die Google Search Console und Google Analytics. Das Ziel des Vortrags ist es Inspirationsquellen für eigene Analysen zu geben.

Was Du nach dem Webinar gelernt hast:

- Inspirationsquellen für eigene Analysen mit Screaming Frog (=Aufzeigen der Funktionsmöglichkeiten)

- Für den eigenen Berufsalltag sofort anwendbare Analysen

- Beispielanalysen: Identifikation von Seiten zur Snippetoptimierung, Bulk Google PageSpeed Check, Linkauditing

Zielgruppe:

- Anfänger

- Fortgeschritten

- Online Marketing Manager

- SEO Manager / SEO-Consultants

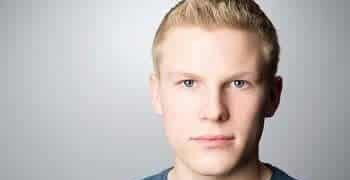

Justin Keirath

Justin Keirath ist seit 2007 im Online Marketing tätig und berät derzeit mittelständische Unternehmen strategisch und begleitet diese bei der Umsetzung von ganzheitlichen Online Marketing Strategien. Ein besonderer Fokus in seiner Arbeit liegt in der Suchmaschinenoptimierung und wie diese möglichst gut mit anderen Marketingkanälen verzahnt werden kann, sodass alle Marketingkanäle innerhalb einer gemeinsamen Strategie zusammenwirken und voneinander profitieren können. Neben langjährigen Erfahrungen im Bereich SEO beschäftigt sich Justin Keirath mit Affiliate Marketing (Publisher), E-Mail Marketing, PPC Marketing sowie dem Vertrieb von digitalen Produkten sowie marktplatzorientierten E-Commerce.