Was ist eigentlich SEO und wozu sollte man Suchmaschinenoptimierung machen? Das und viele weitere Fragen werden Dir in unserer vollumfänglichen SEO Themenwelt beantwortet.

Getreu unserem Motto “Lebenslang voneinander lernen”, kannst Du Dich im Bereich SEO ganzheitlich weiterbilden. Egal ob SEO Einsteiger:in oder Profi, hier findest Du alle wichtigen Basics, hilfreiche SEO-Tipps, klare Handlungsempfehlungen und die neusten SEO-Trends.

Wie möchtest Du lernen? Lese Dich durch unsere Magazinartikel, höre unsere SEO-Podcasts oder schaue Dir hilfreiche Webinare an – wir begleiten Dich bei Deiner Reise durch den OMT-Kosmos.

Auf welchem SEO-Level bist Du und wofür möchtest Du Informationen?

Inhaltsverzeichnis:

Was ist Suchmaschinenoptimierung (SEO)?

SEO steht für “Search Engine Optimization” (deutsch: Suchmaschinenoptimierung) und ist der Oberbegriff für alle Maßnahmen, die den Inhalten einer Webseite helfen, in den unterschiedlichen Suchmaschinen (wie z.B. Google, Amazon, YouTube etc.) auf den gewünschten Suchanfragen (Keywords) weit vorne platziert zu sein. Das Ziel von SEO besteht darin, eine höhere Sichtbarkeit und ein höheres Ranking auf den Suchmaschinenergebnisseiten (SERPs) zu erreichen, um mehr Besucher:innen auf eine Website zu bringen.

SEO umfasst eine Vielzahl von Teildisziplinen, einschließlich Keyword-Recherche, On-Page-Optimierung, Off-Page-Optimierung, Linkbuilding und technischer Optimierung. Durch die Verbesserung dieser Faktoren können Suchmaschinen wie Google eine Website besser verstehen und die Relevanz für bestimmte Suchanfragen erhöhen.

Insgesamt ist SEO ein wichtiger Bestandteil der Online-Marketing-Strategie für viele Unternehmen, da es dazu beitragen kann, den Traffic auf einer Website zu erhöhen und potenzielle Kunden anzuziehen.

SEO als Teilbereich des Suchmaschinenmarketings (SEM)

Die Suchmaschinenoptimierung (SEO) ist ein Teilbereich des Suchmaschinenmarketings (SEM). Die andere Komponente stellt die Suchmaschinenwerbung (SEA) dar.

Der Unterschied zwischen SEO und SEA ist folgender:

SEO umfasst alle Maßnahmen, die unternommen werden, um eine Website für Suchmaschinen zu optimieren, damit sie in den Suchergebnissen höher gerankt wird. Dabei geht es darum, dass eine Website relevante Inhalte und eine suchmaschinenfreundliche Struktur aufweist, damit die Suchmaschine, wie Google die Seite besser indexieren und verstehen kann.

SEA steht für “Search Engine Advertising” und beschreibt alle bezahlten Werbemaßnahmen in den Suchmaschinen. Dazu gehören beispielsweise Google Ads-Anzeigen, die noch über den organischen Suchergebnissen angezeigt werden. Hier bezahlen Werbetreibende für jeden Klick auf die Anzeige und Nutzer:innen werden direkt auf die beworbene Seite weitergeleitet.

Der Unterschied zwischen SEO und SEA liegt also in der Art und Weise, wie die Seiten auf den Suchergebnisseiten platziert werden: SEO versucht, die organischen (nicht bezahlten) Suchergebnisse zu verbessern, während SEA auf bezahlte Werbung setzt.

Im Online Marketing können jedoch beide Methoden kombiniert werden, um eine maximale Sichtbarkeit und Reichweite zu erzielen, da SEO eher der Kanal zur langfristigen Erreichung der Ziele ist, wohingegen bei SEA mit sofortigen Ergebnissen zu rechnen sein kann.

Benötigst Du Unterstützung bei der Suchmaschinenoptimierung oder Suchmaschinenmarketing? Nutze unseren Agenturfinder, um die passende SEO Agentur oder SEA Agentur für Deine Anforderungen zu finden.

SEO besteht aus zwei Bereichen: Onpage- und Offpage-Optimierung

SEO ist selbst noch einmal in zwei große Bereiche unterteilt:

- Die Onpage-Optimierung (alles, was auf Deiner Webseite passiert)

- Die Offpage-Optimierung (alles, was außerhalb Deiner Webseite erledigt werden kann)

Dabei umfasst Onpage rund 3/4 der Suchmaschinenoptimierung und Offpage 1/4. Wie in dem nachfolgenden Schaubild zu erkennen ist, sind die wesentlichen Bestandteile guter Suchmaschinenoptimierung die Teilbereiche Programmierung, Content und Linkaufbau (und ein wenig Social Media, wobei der Einfluss nur indirekt besteht).

Die Suchmaschinenoptimierung (SEO) besteht aus den zwei großen Bereichen, der Onpage- und Offpage-Optimierung. Während der Content auf beide Bereiche der SEO einzahlt, wird der Linkaufbau häufig der Offpage-Optimierung gleichgesetzt und die Art der Programmierung als wesentlicher Faktor in der Onpage-Optimierung angesehen.

Bei der Content-Optimierung sollten relevante Begriffe in Texten eingebunden und ein Mehrwert für die User:innen geschaffen werden. Ebenso kann die Optimierung von Bildern oder Meta-Angaben den Keyword-Fokus einer Webseite abrunden und somit die Seite besonders relevant für ein Thema machen. Die technische Optimierung bezieht sich auf Maßnahmen am Server, am Quellcode oder am verwendeten CMS, wohingegen sich die mobile Optimierung auf die Anpassung einer Website für mobile Endgeräte bezieht.

Aber auch die Offpage-Optimierung (linkegebende Inhalte) können für bessere Erfolge sorgen. Hierzu zählt der Linkaufbau, bei dem versucht wird, die Domain-Popularität durch den Erhalt von Backlinks zu steigern. Gleichzeitig soll durch die Offpage-Optimierung das Vertrauen in eine Webseite erhöht werden. Die Steigerung der Sichtbarkeit im Netz kann durch Content Marketing und Social Media erreicht werden.

Deshalb solltest auch Du auf Suchmaschinenoptimierung setzen

Wenn Du Dich als Unternehmer:in, Geschäftsführer:in oder Marketingbeauftragte eines Unternehmens fragst, ob Du SEO machen solltest, dann lautet die Antwort von mir ganz klar ja. Warum? Ganz einfach: Die Informationsbeschaffung der Menschen wandert Jahr für Jahr weiter ins Internet. Vorbei sind die Zeiten, in denen wir durch Einkaufshäuser gegangen oder uns mit echten Zeitungen informiert haben. Der schnellste und einfachste Weg geht heute über die unterschiedlichen Suchmaschinen im Netz. Egal, ob YouTube, Amazon oder Google, final habe ich ein (Wissens-) Bedürfnis, das ich mit einer gezielten Suchanfrage lösen möchte.

Es ist wichtig, dass wir uns im Prozess der Informationsbeschaffung positionieren, indem wir adäquate (sehr gute) Inhalte veröffentlichen, die unseren Kunden ein Vertrauen in unsere Expertise verschafft. Wenn diese Inhalte suchmaschinenoptimiert aufbereitet werden, werde ich das Trafficpotenzial meiner Webseite massiv steigern und mich zudem an der richtigen Stelle der Customer Journey positionieren.

Was sind die Ziele von SEO?

SEO hat das Ziel, die Sichtbarkeit und das Ranking einer Webseite in den Suchmaschinenergebnissen zu verbessern, um mehr Traffic auf die Seite zu generieren. Dabei geht es vor allem darum, die Webseite so zu gestalten und zu optimieren, dass sie den Anforderungen der Suchmaschinen entspricht und somit als relevant und hochwertig eingestuft wird.

Im Detail können die Ziele von SEO unterschiedlich sein, je nach den individuellen Anforderungen und Zielen eines Unternehmens. Einige häufige Ziele von SEO umfassen:

- Verbesserung der Sichtbarkeit und Auffindbarkeit der Webseite in den Suchmaschinen

- Steigerung des organischen Traffic auf die Webseite

- Erhöhung der Conversion Rate, also der Umwandlung von Besucher:innen in Kunden oder Leads

- Verbesserung des Nutzererlebnisses auf der Webseite durch eine optimierte Benutzerführung und Ladezeiten

- Erhöhung der Markenbekanntheit und Stärkung des Online-Images

- Steigerung der Besucherzahlen aus bestimmten Zielgruppen oder Regionen

- Verbesserung der Inhalte und des Contents der Webseite, um die Nutzerzufriedenheit und die Interaktion mit der Seite zu erhöhen.

All diese Ziele lassen sich durch eine professionelle SEO-Strategie erreichen, die darauf abzielt, die Suchmaschinenoptimierung einer Webseite kontinuierlich zu verbessern und anzupassen.

Welche Vorteile hat SEO im Vergleich zu anderen Kanälen?

Suchmaschinenoptimierung (SEO) hat im Vergleich zu anderen Kanälen wie bezahlter Werbung, Social Media Marketing und E-Mail-Marketing verschiedene Vorteile:

Die Vorteile von Suchmaschinenoptimierung

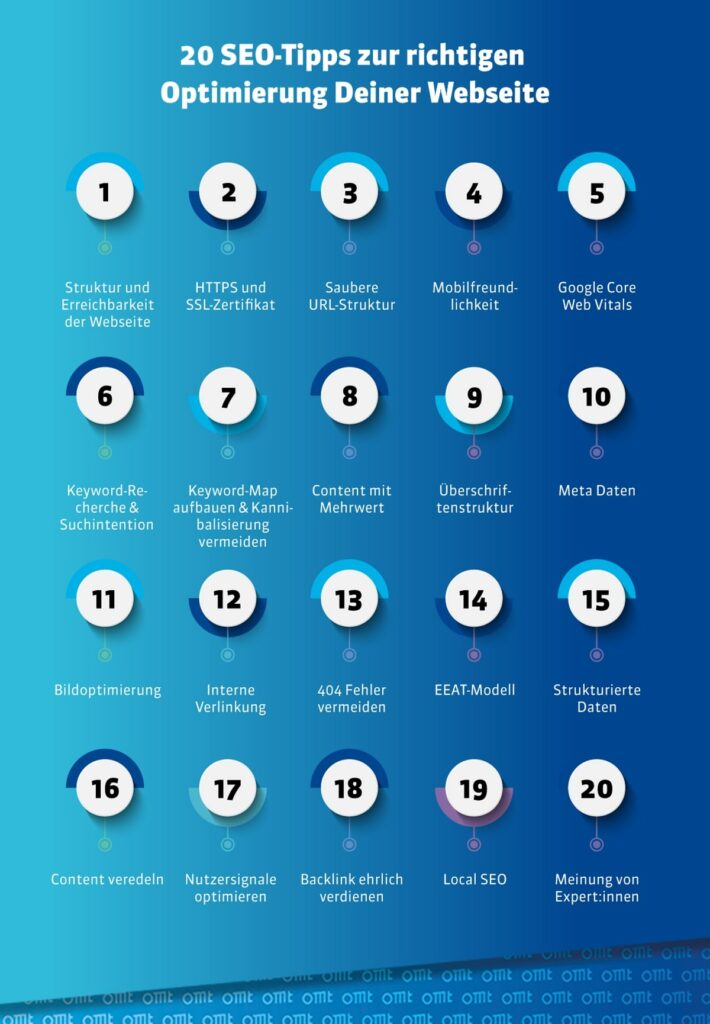

20 SEO Tipps zur richtigen Optimierung Deiner Webseite

Kommen wir ans Eingemachte und dazu, wie Du denn nun SEO richtig anwenden kannst.

Im Folgenden erkläre ich Dir die wichtigsten Elemente, die für eine gute Suchmaschinenoptimierung beachtet werden sollten. Je intensiver Du Dich mit diesen einzelnen Themen und dem Google Algorithmus beschäftigst, desto besser werden Deine Rankings ausfallen.

Sollte ich in einem der folgenden Punkte auch Quick Win-Potenziale sehen, werde ich dies explizit nochmal aufführen. Zudem packe ich Dir unter jeden SEO-Tipp noch einen passenden Verweis zu einem weiterführenden Magazinartikel o. Ä. genau zu dem Thema, falls Du Dich noch intensiver damit beschäftigen möchtest.

SEO-Tipp 1: Die Struktur und Erreichbarkeit der Webseite

SEO-Tipp 2:HTTPS und SSL-Zertifikat sorgt für Sicherheit

SEO-Tipp 3: Eine saubere und suchmaschinenfreundliche URL-Struktur

SEO-Tipp 4: Mobilfreundlichkeit

SEO-Tipp 5: Google Core Web Vitals beachten

SEO-Tipp 6: Keyword-Recherche und Suchintentionen kennen

SEO-Tipp 7: Keyword-Map aufbauen und Kannibalisierung (interner Wettbewerb) vermeiden

SEO-Tipp 8: Content mit Mehrwert bereitstellen

SEO-Tipp 9: Überschriftenstruktur optimieren

SEO-Tipp 10: Meta Daten optimieren

SEO-Tipp 12: Interne Verlinkung

SEO-Tipp 13: 404 Fehler vermeiden

SEO-Tipp 14: EEAT-Modell beachten

SEO-Tipp 15: Strukturierte Daten nutzen

SEO-Tipp 17: Nutzersignale optimieren

SEO-Tipp 18: Backlinks ehrlich verdienen

SEO-Tipp 19: Lass Local SEO nicht aus den Augen

SEO-Tipp 20: SEO-Agentur? Ja oder Nein

SEO-Tipp 1: Die Struktur und Erreichbarkeit der Webseite

Das Wichtigste zuerst: Deine Inhalte müssen für Google abrufbar sein, sprich indexiert sein. Stelle also sicher, dass alle URLs und Inhalte, die Deine Zielgruppe über Suchmaschinen finden sollen, auch im Index und somit technisch auslesbar sind.

Was bedeutet Indexierung?

Der Begriff Indexierung beschreibt die Aufnahme von Informationen in einen Index. Die aufgenommenen Inhalte werden nach bestimmten Kriterien aufbereitet, zum Beispiel indem ihnen Schlagwörter auf Basis der Inhalte zugeordnet werden, und bilden schließlich den Index. Der Index sorgt für eine schnellere Auffindbarkeit der Inhalte.

Bibliotheken arbeiten zum Beispiel mit einem Index, der dafür sorgt, dass bei der Eingabe eines bestimmten Schlagwortes eine Liste von Büchern angezeigt wird, die für dieses Schlagwort relevant sind. Auch Suchmaschinen wie Google arbeiten nach diesem Prinzip: Startet ein:e Nutzer:in eine Suchanfrage, durchsucht die Suchmaschine nicht das Internet, sondern den eigenen Index. (Quelle: Xovi)

Was gibt es schlimmeres als Webseiten, deren Sinn nicht auf Anhieb verstanden wird oder die keine gute Übersicht bieten, also nicht klar ist, wo das Gesuchte gefunden wird. Aber warum? Die Grundstruktur einer Webseite ist das A und O, um eine hohe Nutzerzufriedenheit zu bekommen. Natürlich gehören final auch noch andere Dinge dazu, aber nur wenn ich meinen Besucher oder meine Besucherin in einfachen Schritten zum Ziel führe, habe ich auch eine berechtigte Chance auf dessen Verbleib.

Aber wie macht man das? Grundsätzlich sollte der Inhalt einer Webseite logisch und hierarchisch gegliedert sein.

„Wenn die Nutzer Deiner Webseite die Struktur der Webseite gut erkennen können, dann kann Google das normalerweise auch!”

Die Inhalte bzw. Produkte (bei einem Onlineshop) sollten thematisch passend strukturiert sein, um eine gute Informationsstruktur abzubilden. Eine klare Informationsstruktur ist auch die Grundlage für eine gute Sichtbarkeit in den Suchmaschinen, weil die Crawler eine Domain besser verstehen und indexieren können. Der Google Algorithmus wird die klare Struktur lieben.

Grundsätzlich stelle ich mir immer folgende Fragen, wenn ich die Struktur einer Webseite analysiere:

- Werden die wichtigsten Seiten von der Startseite aus verlinkt?

- Wird von jeder Kategorie auf die Startseite bzw. Ober- und Unterkategorie verlinkt?

- Ist jede Unterseite in 3 Klicks erreichbar?

- Ist der Pfad zu der jeweiligen Unterseite für die Webseiten-Besucher:innen ersichtlich?

- Besteht die Navigation aus Textlinks?

SEO-Tipp 2: HTTPS und SSL-Zertifikat sorgt für Sicherheit

Du kennst das sicher, Du klickst auf ein Snippet auf der Suchergebnisse und es erscheint die Info “Dies ist keine sichere Verbindung”…ätzend! Für gute Suchmaschinenoptimierung ist der Umstieg von HTTP auf HTTPs inzwischen Pflicht. Sorge dafür, dass Deine Website über ein entsprechendes SSL-Zertifikat verfügt. Nicht nur, dass die Absprungrate bei einer solchen Meldung gigantisch hoch ist, es schafft auch überhaupt gar kein Vertrauen bei den User:innen, geschweige denn es gibt Pluspunkte seitens Google…eher führt es zu einer Abstrafung.

SEO-Tipp 3: Eine saubere und suchmaschinenfreundliche URL-Struktur

Mit einer kurzen und “sprechenden” URL bieten wir den Nutzer:Innen eine gewisse Orientierung und können gleichzeitig die SEO (Search Engine Optimization), also die Platzierung der URL positiv beeinflussen. Der User oder die Userin erkennt auf einen Blick, welcher Inhalt auf der jeweiligen Unterseite zu finden ist.

Und je kürzer eine URL ist, desto stärker werden die in der URL vorkommenden Wörter gewichtet. Zudem können sich die Nutzer:innen der Seite eine kurze URL oft einfacher merken.

Allerdings gibt es ein paar Regeln bzw. Maßnahmen, die zum Erhalt einer sauberen URL-Struktur unbedingt beachtet werden sollten. Im Gegensatz zum Meta-Titel bzw. der Meta-Description sollte auf unnötige Füllwörter verzichtet und beim Einsatz von mehreren Wörtern in der URL unbedingt darauf geachtet werden, dass die Wörter mit einem Bindestrich getrennt werden, da dieser wie ein Leerzeichen fungiert.

Zudem sollte auf Sonderzeichen bzw. Umlaute in der URL verzichtet werden. Umlaute werden mit ae, oe oder ue ausgespielt, da sie vor allem im Ausland normalerweise nicht auf der Tastatur zu finden sind.

In einem klassischen Onlineshop würden wir die URL-Struktur folgendermaßen aufbauen:

https://www.onlineshop.de Kategorie

Schuhe:

https://www.onlineshop.de/schuhe/

Unterseite Badeschlappen:

https://www.onlineshop.de/schuhe/badeschlappen/

Wenn ich die URL-Struktur einer Webseite aufsetzen, stelle ich mir immer folgende Fragen:

- Werden sprechende URLs genutzt?

- Sind die genutzten URLs so kurz wie möglich/ so lang wie nötig?

- Wird in der URL das jeweilige Hauptkeyword der Unterseite aufgeführt?

- Wurden Umlaute richtig umgewandelt?

- Wurden Sonderzeichen aus der URL eliminiert?

SEO-Tipp 4: Mobilfreundlichkeit

Wer sich heutzutage mit dem Thema Suchmaschinenoptimierung bzw. Suchmaschinenmarketing beschäftigt, kommt nicht um das Thema „mobile Optimierung“ bzw. “Responsive Webdesign” herum.

“Mobile First” bedeutet, dass bei der Entwicklung einer Website oder einer Anwendung zuerst die Anforderungen und Einschränkungen von mobilen Geräten berücksichtigt werden. Mit anderen Worten, die mobilfreundliche Version der Website oder Anwendung steht im Vordergrund, während die Desktop-Version als sekundär angesehen wird.

Durch die Erstellung einer mobilen Version einer Website oder Anwendung wird sichergestellt, dass sie auf einer Vielzahl von Geräten und Bildschirmgrößen gut funktioniert und eine bessere Nutzererfahrung bietet. Im Zuge von Mobile First wurde übrigens auch das Format AMP eingestellt.

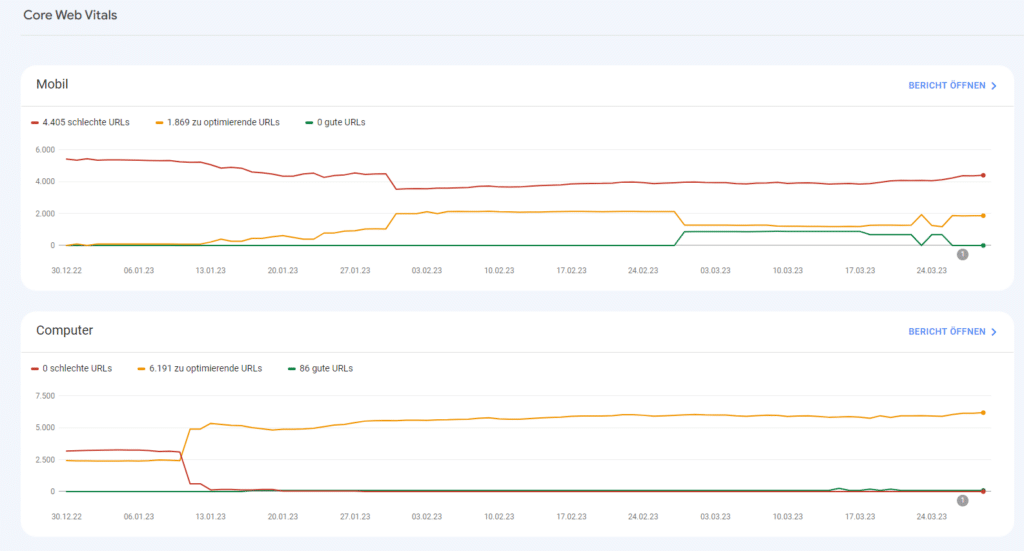

SEO-Tipp 5: Google Core Web Vitals beachten

Google hat 2021 die Web Vitals ins Leben gerufen, um die Performance einer Website noch besser und eindeutiger messen zu können. Vor allem wird das Ziel verfolgt, es den Webmaster:innen anhand des Web-Vitals-Berichts – der mittlerweile Einzug in die Google Search Console gehalten hat – jetzt noch besser verständlich zu machen, wo genau die Defizite einer Website liegen. Dies ist ein klares Indiz dafür, dass Google immer mehr versucht, die Usability einer Webseite als Rankingfaktor aufzunehmen.

Beispiel aus der Google Search Console für die Ansicht Desktop und mobil der Google Core Web Vitals.

Insbesondere spielen dafür 3 wichtige KPIs eine Rolle:

a) Largest Contentful Paint (LCP)

Bei dem Largest Contentful Paint (kurz: LCP) geht es wie beim Page-Speed-Bericht auch, vor allem um die Ladezeit einer Website bzw. einer Unterseite.

b) First Input Delay (FID)

Unter First Input Delay (kurz: FID) versteht man die Wartezeit zwischen der ersten Nutzerinteraktion und der Reaktion des Browsers.

c) Cumulative Layout Shift (CLS)

Der Cumulative Layout Shift (kurz: CLS) misst die „Visual Stability“ – das heißt, wie sehr sich Inhalte im Ladeprozess der Seite noch verschieben.

SEO-Tipp 6: Keyword-Recherche und Suchintentionen kennen

Eine gute Keyword-Recherche ist die absolute Basis jeder Suchmaschinenoptimierung. Dabei ist es irrelevant, ob ich im lokalen oder nationalen Bereich optimiere. In meinen Augen wird die Keyword-Recherche viel zu sehr als Ballast angesehen bzw. als notwendiges Übel.

Und das ist in meinen Augen grundlegend falsch!!!

Gerade bei der Keyword-Recherche trennt sich die Spreu vom Weizen und mit viel Mühe bzw. akribischem Vorbereiten einer Kampagne ist die Grundlage für den späteren Erfolg von Deinem gesamten Suchmaschinenmarketing (dient nicht nur SEO, sondern auch Google Ads-Maßnahmen) deutlich besser gelegt.

Durch die Auseinandersetzung mit der Suchintention, die hinter jedem Keyword liegt, fange ich an, meine User:innen besser zu verstehen. Bitte mache das mit Zeit und Fokus, weil häufig schon ganz leichte Veränderungen im Keyword eine unterschiedliche Suchintention mit sich bringen.

Ein Beispiel?

Stell Dir vor, Du suchst nach dem Keyword “Webinarkonferenz”! Die Suchintention liegt wahrscheinlich darin, dass die Person entweder nach einem Tool-Anbieter sucht oder sich das Wort erklären lassen möchte. Wenn ich das Keyword auf die Mehrzahl (“Webinarkonferenzen”) ändere, dann liegt die Suchintention eher darin, dass nach gezielten Konferenzen gesucht wird, die online stattfinden.

An diesem Beispiel erkennst Du, wie wichtig die isolierte Betrachtung der Suchintention ist. Denn früher wären sicherlich beide Keywords auf das gleiche Thema optimiert worden.

Wir unterscheiden Keywords eigentlich in folgende Bereiche:

1. Transaktionale Suchanfragen

Hierbei handelt es sich um Suchanfragen, die eine Transaktion nach sich ziehen. Das kann eine Bestellung, eine Reservierung, aber auch das Herunterladen einer Software sein. Bitte nicht mit den kommerziellen Suchanfragen verwechseln.

2. Informationsbasierte Suchanfragen

Bei diesen Suchanfragen soll der “Wissensdurst” gestillt werden, sprich die User:innen haben ein Informationsbedürfnis, das er oder sie befriedigt wissen möchte.

3. Kommerzielle Suchanfragen

Hierbei handelt es sich um Suchanfragen, die eine klare Kaufabsicht nach sich ziehen.

4. Navigationale Suchanfragen

Mit diesen Suchanfragen versucht der User oder die Userin direkt bestimmte Unterseiten einer Webseite anzusteuern. Oftmals ziehen diese Suchanfragen auch Brand-Traffic, weil sie häufig mit dem Brand genutzt werden.

5. Brand-Suchanfragen

Hierbei handelt es sich um alle Suchanfragen, die die Brand-Keywords der jeweiligen Seite beinhalten. Das können die Keywords alleine sein bzw. in der Kombination mit anderen Keywords.

6. Lokale Suchanfragen

Hier sind alle Suchanfragen gemeint, die einen Bezug zu einer Stadt oder Region haben. Gerade bei regionalen Dienstleistern sind diese Suchbegriffe häufig sehr entscheidend über den Erfolg eines Unternehmens.

Wenn Du mit der Suchmaschinenoptimierung gerade erst beginnst, lass Dir eins gesagt sein: Falls Du für Deine Suchmaschinenoptimierung noch ein gutes Keyword-Tool brauchst, haben wir hier einen guten Vergleich für Dich zusammengestellt. „Lieber auf einem Nischenkeyword mit weniger Suchvolumen auf Platz 1 ranken, als auf einem Keyword mit viel Suchvolumen auf Platz 26!”

Warum?

Auf Seite 3 bei Google bekommt ein Keyword genauso viel Traffic, wie auf Seite 10 GAR KEINEN!

Da es aber in der Suchmaschinenoptimierung viel schwieriger ist, auf einem stark umkämpften Keyword nach oben zu kommen, solltest Du Dich gerade am Anfang Deiner SEO-Arbeit auf schwach umkämpfte Keywords mit weniger Suchvolumen und hoher Conversion-Wahrscheinlichkeit konzentrieren, da Du hier viel leichter an Traffic (und hoffentlich Conversions) kommst.

Falls Du für Deine Suchmaschinenoptimierung noch ein gutes Keyword-Tool brauchst, haben wir hier einen guten Vergleich für Dich zusammengestellt.

SEO-Tipp 7: Keyword-Map aufbauen und Kannibalisierung (interner Wettbewerb) vermeiden

Wenn Du eine ausführliche Keyword-Recherche gemacht hast, solltest Du Dir genau überlegen, welche Inhalte für welche Keywords ranken sollten. Ziel ist es, jedem Keyword eine URL zuordnen zu können.

„ede URL darf für unendlich viele Keywords ranken, aber ein Keyword darf nur einer URL zugeordnet werden, um Google nicht zu verunsichern!””

Eine genaue Keyword-Zuordnung ist aus mehreren Gründen sehr sinnvoll:

- Saubere Struktur der Webseite

- Internen Wettbewerb reduzieren

Wie oft habe ich es schon gesehen, dass eine Webseite zum gleichen Thema viele Artikel produziert hat. Stell Dir vor, all diese Artikel gehen über „Käsekuchen“. Wenn ich jetzt mehrere Inhalte dazu aufbaue, werden alle diese Inhalte versuchen auf dem Wort “Käsekuchen” zu ranken, was natürlich keinen Sinn macht. Final kann ich vielleicht gar nicht mehr beantworten, welcher der Artikel jetzt der Wichtigste für mich ist. Und wenn ich es nicht beantworten kann, wie soll Google das dann entscheiden? Das Ende vom Lied ist dann, dass Google in so einem Falle gar keinen Artikel dieser Webseite auf Seite 1 anzeigen wird. Ziel verfehlt!

Um dieses Problem auszumerzen, baut sich ein gut strukturierter Suchmaschinenoptimierer eine ausführliche Keyword-Map und definiert vorab, welcher Inhalt auf welchem Keyword ranken soll.

Und wenn ein Keyword doch auf einer anderen URL genannt wird, weiß ich auf Basis unserer Keyword-Map, dass ich dieses Wort mit der von mir gewünschten URL verlinken muss. Auf diese Art und Weise suggeriere ich dem Google Algorithmus, welche URL diejenige ist, die unter diesem Keyword in den Ergebnissen ranken soll.

Zum Erstellen einer solchen Keyword-Map nutzt Du am besten Excel. Damit es noch einfacher wird, habe ich Dir ein Beispiel bereitgestellt, dass Du unter dem folgenden Link einfach downloaden kannst. Eine kleine Hilfestellung, damit Du keine eigene bauen musst.

Bitte beachte, dass die Keyword-Map ein ständiger Begleiter Deiner Suchmaschinenoptimierung ist. Über die Keyword-Map entdeckst Du bei Wettbewerbsvergleichen sehr schnell die Lücken in Deinem Content.

Zudem behältst Du auch langfristig sehr gut im Überblick, mit welchen Inhalten Du Dich schon befasst hast und mit welchen nicht. Auf diese Weise lässt sich die Struktur der Webseite sehr sauber halten, interner Wettbewerb sehr einfach ausschließen und die allgemeine Strategie jederzeit anpassen.

SEO-Tipp 8: Content mit Mehrwert bereitstellen

„Keine Rankings ohne Keywords. Keine Keywords ohne Content.”

Da Google weiterhin in erster Linie eine auf Text basierende Suchmaschine ist, hat der Text weiterhin eine hohe Relevanz für den Erfolg Deiner Suchmaschinenoptimierung (Search Engine Optimization).

„Erstelle Texte für die Nutzer:innen und nicht für die Suchmaschine!”

Leicht gesagt, aber schwer umgesetzt. Die Hauptfrage, die Du Dir immer wieder stellen musst, wenn Du Content produzierst: Bietet der produzierte Content einen echten Mehrwert? Wenn Du diese Frage nicht mit Ja beantworten kannst, dann kannst Du Dir die Zeit auch sparen!

Überlege Dir ganz genau, welches Informationsbedürfnis Deine Nutzer:innen bzw. potenziellen Kunden haben und versuche dieses zu befriedigen. Das können Inhalte sein, die nah an der Conversion orientiert sind (z.B. Produkttests) oder Inhalte die hinführend zu einem Thema passen (z.B. das Thema Gesundheit, wenn ich Laufschuhe verkaufen möchte!).

Bei den Inhalten geht es nicht darum, dass Du Deine Produkte oder Firma in den Mittelpunkt stellst, sondern um die Erstellung von Content, die einen als Experten oder beste Anlaufstelle zu dem Thema erscheinen lässt.

Typische Inhalte mit Mehrwert sind E-Books, Whitepaper, Webinare, Checklisten oder Studien sind eine gute Maßnahme. Natürlich fallen auch Magazinartikel darunter, insofern mit einer gewissen fachlichen Tiefe geschrieben wurden.

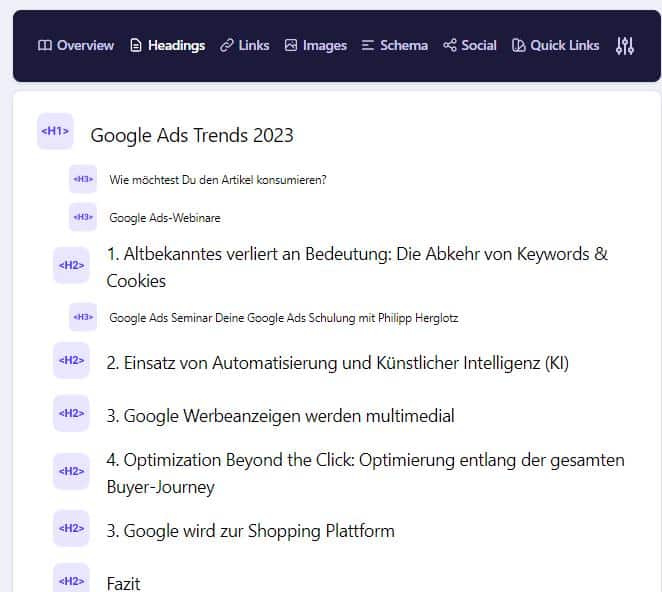

SEO-Tipp 9: Überschriftenstruktur optimieren

Die Überschriftenstruktur ist das semantische Rückgrat Deiner Web- bzw. Unterseite!

Gerade in Zeiten absoluter “Contentüberflutung” wird die Überschriftenstruktur immer wichtiger, um den Leser:innen einen schnellen Überblick zu geben, um was es in einem Artikel überhaupt geht. Oftmals sind die Überschriften auch die Basis der Inhaltsangabe eines Textes, was zusätzlich hilft, um a) noch einen besseren Überblick zu bekommen und b) mithilfe von Sprungmarken die Leser:innen an die für ihn relevanten Textstellen zu navigieren.

Hier ist eine klare Überschriftenstruktur zu erkennen. Aufsteigend, von h1 zu h2 und h3. h3-Elemente sind Unterthemen, wiederum von h2-Überschriften.

Screenshot OMT-Magazinartikel H-Struktur > Tool: Chrome Extension Detailed SEO Extension

Folgende Überschriften gibt es (und sind für die Suchmaschinenoptimierung relevant):

h1: Es darf maximal eine h1 pro Unterseite existieren. Die h1 ist sehr SEO-relevant und sollte auch immer Dein wichtigstes Keyword für die Unterseite tragen. Im Normalfall sollte die h1 auch die Headlines des jeweiligen Dokumentes sein und hat zudem das Ziel, die Aufmerksamkeit deiner Leser zu wecken und so für eine höhere CTR von Google auf deine Webseite zu sorgen.

h2: Die h2-Überschriften bieten eine gute Möglichkeit, sogenannte semantisch relevante Keywords (zum Hauptkeyword) oder verwandte Schlüsselbegriffe zu verwenden. Zudem sollten die h2-Überschriften den Artikel in seine wichtigsten Bereiche unterteilen.

Kleiner Tipp: Die h2 ist ein guter Platz für Fragen und kann über die strukturierten Daten als Google Answer-Box ausgezeichnet werden.

h3: In der Reihenfolge der Überschriftenstruktur sind diese Überschriften den nicht so wichtigen Themen vorbehalten. Aber was schon für die h2 gilt, gilt auch für die h3. Der perfekte Platz, um weitere semantisch passende Keywords zu platzieren.

Checkliste für Deine Überschriftenstruktur:

- Hat Deine Unterseite genau eine h1-Überschrift?

- Ist diese h1-Überschrift einzigartig und regt zum Klicken an?

- Ist das Hauptkeyword dieser Unterseite integriert?

- Sind in der h2 und h3 semantisch passende Keywords integriert?

SEO-Tipp 10: Meta Daten optimieren

Die Meta Daten sind der erste Berührungspunkt, den User:innen mit Deiner Website haben, nämlich dann, wenn Sie Dein Snippet zu ihrer eingegebenen Suchanfrage in den SERPs sehen. Das Wettrennen um den Klick beginnt. Natürlich ist die Platzierung deines Snippets auf der Suchergebnisseite noch viel relevanter als der Text, das zeigt auch die CTR Studie von Sistrix (2020), die ich übrigens auch nach über 2-3 Jahren immer noch hochgradig interessant finde.

Dennoch ist vor allem der Seitentitel hochrelevant für Deine Suchmaschinenoptimierung und pusht Deine Ergebnisse. Zudem ist er das auffälligste Element in dem jeweiligen Google Snippet. Wie groß der Einfluss einer Titel-Optimierung in Verbindung mit einer höheren Klickrate (CTR) von Google auf Deine Webseite ist, zeigt uns Felix Meyer in diesem Webinar:

Checkliste für Deinen optimalen Meta-Title:

- Der Titel ist aussagekräftig und unique

- Der Titel hat eine maximale Pixelbreite von 512 Pixeln (entspricht ca. 55 Zeichen)

- Der Nutzer oder die Benutzerin wird durch den Titel zum Klicken angereizt

Die Optimierung des Google Snippets und vor allem des Titles ist für mich eine der Maßnahmen schlechthin in Bezug auf sogenannte SEO-Quickwins. Ja, SEO dauert lange. Manchmal 12 bis 18 Monate bis die Maßnahmen der Strategie ihre ersten Früchte tragen. Das gilt aber vor allem für Seiten, die noch nicht lange am Markt sind bzw. nich viel Content tragen.

Bei Webseite, die zwar nie optimiert wurden, aber schon lange online sind und regelmäßig Content generieren, gibt es meistens sehr viele “Low Hanging Fruits”, die geerntet werden können. Es macht also Sinn, sich Gedanken über langfristige Strategien zu machen, es sollte aber auch auf die Quickwins geachtet werden. Und hier spielt die Optimierung der Google Snippets eine große Rolle. Mit einer attraktiveren Gestaltung der Snippets kann ich von heute auf Morgen mehr Traffic aus den bestehenden Einblendungen bei Google generieren. Die Erfolgschance einer Optimierung der Snippets ist meistens sehr hoch und vor allem “relativ” unmittelbar, weshalb dieser Aspekt immer ein wichtiger Teil einer SEO-Strategie sein sollte.

Macht Euch immer Gedanken, zu welchem Keyword eine URL ranken soll und schaut Euch die bestehenden Suchergebnisse an. Meistens reicht ein Blick, um zu erkennen, welche Snippets in den Suchergebnissen besonders gut funktionieren.

Die Meta-Description hat im Vergleich zum Titel-Tag keinen direkten Einfluss auf den Google Algorithmus. Der indirekte Einfluss in Form einer CTR-Steigerung ist aber nicht von der Hand zu weisen. Auch wenn der Meta-Title sicherlich den höheren Impact auf die CTR hat, solltest Du auch bei der Meta-Description sehr konsequent sein und sowas wie einen Call-to-Action, Keywords und Icons verwenden, um die Aufmerksamkeit bei den Nutzer:innen zu erhöhen.

Bedenke, Dein Title-Tag wird immer von Google in den SERPs angezeigt, bei der Meta-Description verfasst Google oft gerne eigene Texte und Dein manuell verfasster Text wird nicht ausgespielt.

SEO-Tipp 11: Bildoptimierung

Die Bildoptimierung ist ein sehr entscheidender Faktor in der Suchmaschinenoptimierung, weil ein falsches Einbinden zu gravierenden SEO-Folgen führen kann. Zu „schwere“ Bilder verlangsamen eine Webseite und sorgen somit für längere Ladezeiten und damit zu Rankingverlusten.

Andererseits bieten die Bilder eine sehr gute Chance, die Platzierung eines Contentstücks deutlich zu verbessern, indem mehr Druck auf die ausschlaggebenden Keywords erzeugt wird. Bilder bieten mehrere gute Gelegenheiten, um sinnvolle Suchbegriffe zu platzieren:

Bildtitel

Hier solltest Du drauf achten, dass das Bild vor dem Hochladen im System schon richtig benannt wird. Achte ebenfalls drauf, dass der Titel das Bild sehr gut beschreibt, aber auch das Hauptkeyword beinhaltet.

URL

Wenn der Titel richtig gewählt wurde, bildet sich in der Regel auch die URL auf Basis des Titels. Das bedeutet, wenn Du Dein Keyword im Titel hast, ist es normalerweise auch in der URL berücksichtigt.

Bildunterschrift

Nicht immer machen Bildunterschriften Sinn. In einem Shop, wo für ein Produkt diverse Bilder eingebunden wurden, kann eine Bildunterschrift nicht gut aussehen. In einem Blogartikel ist die Bildbeschreibung oftmals sehr sinnhaft und bietet eine weitere sehr gute Möglichkeit, um Keywords (bzw. semantische Keywords) einzubauen.

Alt-Tag

Der Alt-Tag ist sehr wichtig, da zum Beispiel sehbehinderte Menschen so einen barrierefreien Zugang zu den Inhalten bekommen. Hintergrund ist, dass Screenreader bzw. Voicebrowser den Inhalt der Bilder vorlesen.

Früher war der Alt-Tag sehr wichtig, dass gerade die Browser, die ein Bild nicht anzeigen konnten, etwas zum Ausspielen hatten. Je mehr wir heutzutage in das Thema Voice-Search „wandern“, desto wichtiger wird die Funktion wieder werden.

Früher hatte auch die Bildersuche von Google eine wichtige Traffic-Rolle gespielt, aber das hat sich in den letzten Jahren sehr zum Negativen verändert. Eigentlich gibt es zurzeit kaum Trafficerwartungen über die Bildersuche, aber der Einfluss auf das jeweilige Dokument ist weiterhin nicht zu unterschätzen.

SEO-Tipp 12: interne Verlinkung

Eine interne Verlinkung kann im Suchmaschinenmarketing immer aus zwei Gründen aufgebaut werden:

- CRO-Sicht: Ich will den User oder die Userin leiten, am besten zu einer Conversion.

- SEO-Sicht: Ich will den Linkjuice an die richtigen Stellen führen.

Der Suchmaschinenoptimierer kümmert sich natürlich in erster Linie um den zweiten Punkt, wobei auch die CRO-Thematik aus Sicht der Nutzersignale nicht komplett zu vernachlässigen ist.

Je häufiger ein Inhalt intern verlinkt ist, desto stärker steigt er in der Priorität und somit in der Gunst der Suchmaschine. Anders ausgedrückt wird so immer mehr externer Trust (Linkjuice) auf die Unterseite geleitet und die Rankingwahrscheinlichkeit wird erhöht.

Als Basis sollte immer die Keyword-Map dienen. Die Inhalte, die dort einem Keyword zugeordnet werden, sollten dann auch unter diesem Keyword intern verlinkt werden.

Eine ausführlichere Vorgehensweise zum Thema interner Verlinkung findest Du in unsere Magazin-Artikel vom Stephan Czysch zum Thema „Interne Verlinkung optimieren: das How-to für bessere SEO-Rankings“!

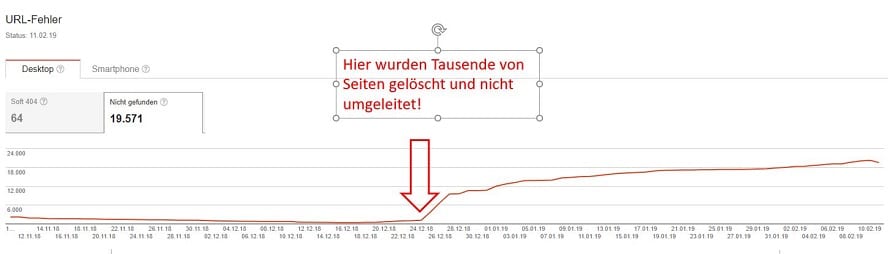

SEO-Tipp 13: 404 Fehler vermeiden

Zu viele 404-Fehler sind ein klarer Hinweis für Google, dass Du Deine Webseite nicht im Griff hast. Dein Ziel sollte es immer sein, so wenige 404-Fehler wie möglich auf der Webseite zu haben.

404-Fehler entstehen aus den unterschiedlichsten Gründen. Typischerweise verliert ein Shop ein Produkt aus dem Sortiment und es wird gelöscht. Wenn das Produkt aber über Google gefunden wird bzw. das Produkt vielleicht sogar intern auf der Domain verlinkt wurde, dann kommen die 404-Fehler, wenn die Produkt-URL nicht 301 weitergeleitet wurde.

Das Schöne ist, dass uns Google mithilfe der Google Search Console ein Mittel an die Hand gibt, die 404-Fehler unserer Domain zu erkennen und zu analysieren. Google zeigt uns sehr granular, welche URL die Fehler aufwirft und wie sie entstehen.

Aufgrund ihrer negativen Effekte auf unsere Suchmaschinenoptimierung gilt es die Zahl der 404-Seiten auf ein Minimum zu reduzieren, indem die fehlerbehafteten URLs auf themenrelevanten Unterseiten umgeleitet werden.

Noch ein kleiner Tipp: Bitte richte eine ordentliche 404-Seite ein, die auch eine gute Möglichkeit zur weiteren Navigation auf der Webseite ermöglicht. Alle 404-Aufrufe sind nicht vermeidbar, alleine schon, wenn jemand einen einfachen Type-In-Fehler auf der Webseite begeht.

Oder, wenn jemand einen externen Link auf unsere Webseite setzt und in der URL einen Schreibfehler macht. Mit einer guten 404-Page retten wir vielleicht ein paar der User und können sie trotzdem von unserem Service überzeugen, bevor sie einfach abspringen.

SEO-Tipp 14: EEAT-Modell beachten

Google hat in seinen Quality Rater Guidelines bestimmte Qualitätskriterien und Metriken zur Content Erstellung definiert. Google EEAT steht für Experience, Expertise, Authoritativeness und Trustworthiness, wobei der Faktor “Experience” erst im Dezember 2022 von Google ergänzt wurde.

Der Google Algorithmus ist mittlerweile soweit Inhalte, die von Expert:innen der Branche verfasst wurden und die über umfassende Kenntnisse in ihrem Fachgebiet verfügen (Expertise) besser zu bewerten. Außerdem sollte die Autorität der Website, auf der die Inhalte veröffentlicht werden, hoch sein (Autorität). Schließlich sollten die Inhalte vertrauenswürdig und glaubwürdig sein, um das Vertrauen der Nutzer zu gewinnen (Trustworthiness).

Daher ist es für Website Betreiber:innen wichtig, hochwertige Inhalte zu erstellen, die von Expert:innen verfasst werden und auf einer vertrauenswürdigen Website veröffentlicht werden. Dies kann dazu beitragen, dass die Website von Google als qualitativ hochwertig eingestuft und in den Suchergebnissen höher eingestuft wird.

Du kannst darauf konkret optimieren, indem Du bspw. Autorenboxen unter Deine Artikel einfügen, um zu zeigen,dass die Inhalte von Expert:innen der Branche verfasst wurden, Trust-Elemente auf der Website einbinden oder Ähnliches.

SEO-Tipp 15: Strukturierte Daten nutzen

Schau mal, an welchen Stellen Du auf Deiner Website strukturierte Daten verwenden kannst. Diese helfen Suchmaschinen wie Google, bestimmte Informationen, wie zum Beispiel Bewertungen, Öffnungszeiten oder Veranstaltungsdaten, auf einer Website hervorzuheben und als Rich Snippets in den Suchergebnissen anzuzeigen.

Rich Snippets sehen beispielsweise so aus, wenn unsere hauseigenen Seminare, passend zu SEO unter der Meta Description angezeigt werden.

Das bringt Dir nicht nur mehr Aufmerksamkeit in den SERPs, sondern durch die Verwendung strukturierter Daten kann Deine Website auch besser in den Suchergebnissen positioniert werden, was zu einer höheren Sichtbarkeit und einer höheren Klickrate führen kann.

SEO-Tipp 16: Content veredeln

Wir haben schon erklärt, wie wichtig es ist, Content mit Mehrwert zu erstellen. Noch wichtiger ist es aber, mit diesem Content weiterzuarbeiten. Einerseits, um ihn aktuell zu halten, andererseits, um ihn immer weiter zu optimieren und ihn zu immer besseren Suchmaschinenrankings zu verhelfen.

Es ist aus mehreren Gründen viel effektiver, einen bestehenden Artikel weiter zu optimieren, als immer wieder neue Artikel zu erstellen. Google liebt aktuelle Inhalte und indem ich einen Inhalt immer weiter optimiere, suggeriere ich Google, dass ich meine Artikel immer auf dem neusten Stand halte. Ein wesentlicher Aspekt, dass Google uns dauerhaft für die Top-Positionen berücksichtigt.

Bevor Du einzelne Seiten optimiert und aktualisiert, solltest Du Dir Deine Website im Ganzen anschauen. Das funktioniert sehr gut über einen Content Audit. Schaue Dir die aktuelle Performance der Inhalte an und entscheide auf Basis von KPIs, welche Inhalte Du optimieren, verwerfen oder auch zusammenfassen möchtest. Gerade in der Vergangenheit und unter den alten “SEO Mythen” wurden oft einfach Seiten erstellt, getreu dem Motto Quantität vor Qualität. Das bringt die Gefahr einer Kannibalisierung, wie bereits in Punkt 11 beschrieben.

In meinen Augen gibt es zwei Punkte auf deren Basis der Content veredelt werden sollte:

Auf Keyword-Ebene

Ich analysiere jede Unterseite und jeden Artikel im Blog auf den aktuellen Stand der Suchbegriffe. Gibt es Chancenkeywords als Keywords, die sich aktuell nahe am Traffic (also zum Beispiel auf Seite 2 oder 3 bei Google) befinden und ein angemessenes Suchvolumen haben? Das kannst Du mit Keyword-Tools wie Sistrix oder Searchmetrics machen.

Im Folgenden mache ich dann eine TF*IDF-Analyse des Inhalts und schau mir an, welche semantischen Keywords fehlen und welche öfter erwähnt werden sollten, wenn ich auf dem jeweiligen Keyword weiter vorankommen möchte.

Bitte achte auch hier darauf, dass Du das nicht maximal optimieren musst. Final darf der Artikel nicht unleserlich werden und muss dem User weiterhin eine gute und interessante Lesbarkeit ermöglichen.

Auf Nutzerdaten-Ebene

Genau wie auf Keyword-Basis kann ich einen Artikel auch auf Nutzerdaten-Basis veredeln. Hier kann man sich auf die Optimierung der Absprungrate, der Seiten pro Sitzung und als wichtigsten Wert die durchschnittliche Sitzungsdauer fokussieren, wobei die Absprungrate durch die Umstellung auf Google Analytics 4 nicht immer so relevant wird.

Die Absprungrate und Seiten/Sitzung sind sehr gut beeinflussbar, indem ich relativ prominent andere interessante Inhalte über die interne Verlinkung platziere und somit einen Anreiz gebe, einen zweiten Klick zu machen. Je mehr Inhalte ich so aufbaue, desto besser wird die Quote.

Das Ziel einer besseren durchschnittlichen Sitzungsdauer lässt sich sehr gut durch die Anreicherung von sinnhaften Videos bzw. durch eine Verlängerung der Texte erreichen.

Beide Herangehensweisen sind sehr effektiv und führen zu deutlichen Erfolgen. Wer bis heute immer nur an eine Anhäufung von Content im eigenen Blog, statt an die Perfektionierung von Content denkt, sollte umdenken. Die Effekte sind enorm, zudem wird der Expertenstatus viel mehr durch die inhaltliche Qualität als durch Quantität verbessert.

SEO-Tipp 17: Nutzersignale optimieren

Schon länger existiert eine breite Debatte unter SEOs, ob User Signale einen großen Einfluss auf die Rankings haben oder nicht. Dies liegt unter anderem an Googles öffentlichen, teils paradoxen Äußerungen zu dem Nutzersignale. Umso wichtiger ist es, die vorliegenden Informationen zusammenzutragen und eine Einordnung zu ermöglichen.

Zunächst die theoretische Grundlage der Debatte: Nutzersignale sind Signale, welche der User durch die Art seiner Nutzung von Online-Inhalten an die Suchmaschine schickt – beispielsweise durch sein Klickverhalten, die Verweildauer oder die Return-to-SERP-Rate”. Einige Experten nehmen an, dass solche Signale einen Einfluss auf das Ranking einer Webseite haben.

Dieser Gedanke rührt aus der logischen Kausalität zwischen der Qualität oder Relevanz eines Suchergebnisses und dem Userverhalten.” Theoretisch liefern User-Signale also wertvolle Anhaltspunkte für die Bewertung von Webseiten, um die Relevanz der Suchergebnisse je nach Suchanfrage für die Nutzer:innen zu optimieren. Es stellt sich die Frage, ob oder wie Google diese Daten nutzt.

Diese beiden Sätze der Einleitung habe ich mir übrigens in einem Artikel zum Thema Nutzersignale “geklaut”, den der Niels Dahnke hier beim OMT verfasst hat. Prädikat “Leseempfehlung”.

Aber, egal, ob Google die Nutzersignale direkt oder indirekt nutzt, sie haben nachweislich einen Effekt auf das Suchmaschinenranking. Nicht umsonst predigt das Unternehmen seit Jahren: “Baut Eure Webseite für die User und nicht für die Suchmaschine!” Langfristig wird es immer wichtiger, weil Google immer fähiger wird, die Usability einer Seite zu bewerten. Warum sollte diese Bewertung nicht auch in die Einstufung der Rankings mit einfließen?

Auf folgende Punkte würde ich im Rahmen der Nutzersignal-Optimierung wert legen:

1. Optimierung der Verweildauer

Eine längere Verweildauer ist nicht per se von Vorteil. Es gibt auch Webseiten, die gar nicht auf eine lange Verweildauer ausgelegt sind. Das betrifft vor allem Webseiten, die nur eine klare Information vermitteln oder ein einfaches Ziel verfolgen. Aber gerade wenn ich mit vielen Informationen “auftrumpfe”, indem ich eine holistische Landingpage zu einem Thema aufbaue, macht natürlich schon Sinn, auf eine lange Verweildauer zu optimieren.

2. Reduzierung der Bounce-Rate

Auch die Bounce-Rate ist alleingestellt kein Faktor, der ausschlaggebend ist. Wenn ich eine holistische Seite zu einem Topic baue und wirklich ALLE Informationen zu einem Thema abdecke, dann kann der Leser oder die Leserin natürlich auch direkt wieder abspringen und es ist kein Beinbruch. Das würde aber die Return-To-The-Serps-Rate wahrscheinlich verbessern. Pauschal lässt sich aber wahrscheinlich sagen, dass eine niedrigere Bounce-Rate erstmal besser ist. Aber grundsätzlich muss der jeweilige Fall bewertet werden.

3. Verbesserung der Ladezeit (Pagespeed)

Speed ist Trumpf. Wer hat schon Bock auf einer langsamen Webseite zu surfen? Klar, dass die Besucher:innen bei einer niedrigen Ladegeschwindigkeit abspringen und schlechte Nutzersignale hinterlassen. Schaut, dass ihr hier zusammen mit der Programmierung optimiert, auch die Core Web Vitals werden sich dadurch verbessern.

4. Verbesserung der “Return-To-The-Serp-Rate”

Viele kennen diesen Begriff gar nicht. Das Problem ist zudem, dass wir ihn nicht messen können. Im Endeffekt bedeutet es nichts anderes, als die Leute auf der Webseite so “zu fangen”, dass sie nicht auf den Back-Button im Browser klicken. Das vielleicht schlechteste Signal, das ich einer Webseite geben kann. Du optimierst diesen Wert, indem Du Deine Webseite immer besser auf den Kunden ausrichtest und fortlaufend verbesserst. Weißt Du, was der Intent Deiner Nutzer:innen ist? Dann versuche diesen zu bedienen!

5. CTR (Click-Through-Rate) von Google auf unsere Webseite

Dieser Punkt geht einher mit der Optimierung der Meta Daten. Sind diese klickattraktiv und auffällig, ist die Chance größer, dass User:innen auf Dein Snippet klicken, anstatt auf das der Wettbewerber. Voraussetzung ist natürlich ein Ranking in den Top 3. Was man hier auch noch machen kann, ist die Nutzung von strukturierten Daten, dazu gleich mehr.

SEO-Tipp 18: Backlinks ehrlich verdienen

Last but not least gehört neben den technischen und inhaltlichen Aspekten auch noch der Bereich des Linkbuildings (Offpage-Optimierung) in die Strategie einer guten Suchmaschinenoptimierung. Gerade in sehr umkämpften Branchen sind gute Links, sprich gute Offpage-Arbeit von Nöten, um sich in den Top 10 zu platzieren.

Aber Vorsicht: Kein anderer Bereich ist so umstritten wie der aktive Linkaufbau. Während die einen Suchmaschinenoptimierer die Finger ganz bewusst von der ganzen Offpage-Arbeit lassen, schwören andere auf die Effekte.

Kein Bereich in der Suchmaschinenoptimierung sorgt für mehr Portenzial für Abstrafungen seitens Google als die Disziplin des Linkbuildings und ist für viele SEO-Interessierte schwer zu durchschauen.

Mein Tipp an der Stelle ist, zahle kein Geld für Backlinks, sondern investiere Dein Geld in gute Strategien. Plane gute Kampagnen, mit denen Du durch perfekten Content gute Backlinks (Empfehlungen) von themenrelevanten Webseiten bekommst.

Schau Dir mein Webinar an und überlege, wie Du die von mir angebrachten Linkbuildingideen für Dich und Deine Domain adaptieren kannst, um sinnvoll durch themenrelevante Backlinks mehr Linkjuice auf Deine Webseite zu holen.

„Content, Links & Rankbrain sind die drei wichtigsten Rankingfaktoren!”

Denkt dran: Linkkauf ist nicht nur rechtlich fragwürdig, sondern stellt sich auch ganz klar gegen die Google-Richtlinien und bietet somit eine konstante Angriffsfläche für potenzielle Penalties.

Aber wenn Du Dich grundlegend in das ganze Offpage-Thema reindenkst, wird Dir sicherlich die eine oder andere innovative Idee kommen, wie Du Deine Webseite verlinken lassen kannst.

Übrigens biete ich hier beim OMT für alle Offpage-Interessierte ein Linkbuilding-Seminar an, in dem wir uns einen ganzen Tag dem Thema widmen. Schau doch mal vorbei!

SEO-Tipp 19: Lass Local SEO nicht aus den Augen

Du möchtest ein lokales Produkt oder Dienstleistung vermarkten? Dann solltest Du auch Local SEO in Betracht ziehen.

Local SEO steht für “Local Search Engine Optimization” und bezieht sich auf die Optimierung von Online-Inhalten, um Unternehmen oder Dienstleistungen in den lokalen Suchergebnissen bei Suchmaschinen wie Google besser sichtbar zu machen.

Die Optimierung erfolgt durch eine Kombination von Techniken wie der Einrichtung eines Google My Business Profils, der Optimierung der Website-Inhalte und -Struktur, der Erstellung von Inhalten, die auf lokale Suchanfragen abzielen, und der Verwendung von lokalen Keywords.

Durch eine effektive Local SEO-Strategie können Unternehmen ihre Sichtbarkeit in den lokalen Suchergebnissen verbessern, mehr Traffic auf ihre Website generieren und letztendlich mehr potenzielle Kunden in ihr Geschäft bringen.

20 Tipps für Deine Suchmaschinenoptimierung

SEO-Agentur? Ja oder Nein

Als finalen Tipp (eigentlich Tipp 20) möchte ich noch auf den Aspekt eingehen, ob es sinnvoll ist, eine Agentur zu beauftragen. Einige der Leser:innen wissen vielleicht, dass ich als Geschäftsführer der ReachX hier vorbelastet bin. Ich versuche es aber mal neutral zu betrachten. Tatsächlich empfehle ich jedem Unternehmen, eigene Online Marketing Expert:innen einzustellen.

Das große Problem ist aber die Erfahrung und vor allem der Vergleich. Während ein Unternehmen meistens nur die Entwicklung der eigenen Webseite im Auge hat, hat eine Agentur viele Projekte zu betreuen und kann vor allem auch bei großen Rankingverlusten meist schnell erkennen, was das Problem ist.

Warum?

Es gibt den Vergleich und wir können ähnliche Projekte heranziehen, um auf Fehlersuche zu gehen. Zudem macht die Beauftragung einer Agentur immer Sinn, wenn ich massiv an meiner Strategie arbeite. Quasi als Challenging-Partner.

Ich rate somit immer jedem Auftraggeber, der die Umsetzung seiner SEO-Maßnahmen durch uns beauftragt, langfristig darüber nachzudenken, diese Aufgaben in sein Unternehmen zurückzuholen und die Agentur aus Aspekten der Kontrolle (zweite Meinung) zu beauftragen oder im Sinne einer besseren Kontrolle der Mitarbeiter:innen, um diese kritisch zu hinterfragen.

Wie lange dauert es denn jetzt, bis die SEO-Maßnahmen greifen?

Wie SEOs gerne sagen “Es kommt drauf an”. Diese Frage ist pauschal gar nicht zu beantworten. Wie schnell man Erfolge erzielt, hängt von vielen Faktoren ab, einschließlich des Wettbewerbsniveaus in der Branche, der Größe und Komplexität der Website, der Qualität der Inhalte und Backlinks sowie der angewendeten SEO-Strategie.

Es ist auch wichtig zu beachten, dass SEO ein fortlaufender Prozess ist, der kontinuierliche Anstrengungen und Optimierungen erfordert. Es ist daher nicht nur wichtig, dass man anfangs Zeit und Ressourcen investiert, sondern auch, dass man sich langfristig engagiert, um die Ergebnisse zu erhalten oder zu verbessern.

Selbst wir beim OMT merken einige Optimierungen sofort, andere nach ein paar Wochen und andere erst nach Monaten. Grundsätzlich kann man aber sagen, dass Veredelungen schneller greifen als komplett neue Texte. Auch bei neuen Backlinks kann man relativ schnell eine Verbesserung des Rankings erkennen oder bei Optimierungen für Quick Wins, wie z.B. Meta Daten.

SEO-Analyse: diese KPIs solltest Du kennen

Für viele ist SEO mit der Veröffentlichung von Seiten oder der Optimierung meist abgeschlossen, dabei ist die regelmäßige Analyse von SEO KPIs extrem wichtig, um langfristig die Inhalte zu veredeln und den organischen Traffic zu steigern. Schließlich willst Du ja keine Entscheidungen aus dem Bauch heraus treffen, sondern möglichst datenbasiert.

Final ist natürlich immer der Umsatz wichtig, aber die Umsatzsteigerung eines Shops kann durch unterschiedliche Optimierungsmaßnahmen beeinflusst werden. Zudem ist durch die langen Reaktionsphasen der SEO-Arbeit der Erfolg oftmals nicht perfekt aufzuschlüsseln. Aus diesem Grund konzentrieren wir uns im Rahmen der SEO-Arbeit auf hinführende Kennzahlen, die uns aufzeigen, dass die Optimierungsmaßnahmen in die richtige Richtung gehen.

Wichtige Größen könnten sein:

- Anteil des SEO-Traffics am Gesamttraffic

- Steigerung des SEO-Traffics nach Abzug des Traffics über Brand-Keywords

- die Verweildauer

- die Bounce-Rate einzelner Unterseiten

- die Click-Through-Rate (Klickrate) von Google auf meine Webseite (messbar über die Google Search Console)

- usw.

Wichtig ist hier vor allem, dass nicht eine pauschale Zahl für die ganze Webseite herangezogen, sondern jede Landingpage einzeln bewertet und mit der Suchintention jedes einzelnen Keywords in Verbindung gebracht wird.

Das Heranziehen allgemeiner Sichtbarkeitindizes wie Sistrix, Xovi, Searchmetrics & Co, halte ich für keine gute Größe, weil die Zahlen relativ wenig Aussagen. Wir sehen immer wieder Steigerungen im Traffic, ohne dass die Sichtbarkeit in den Tools nach oben geht (aber auch umgekehrt).

Behalte aber auch Dein Domain-Rating in Bezug auf Backlinks im Auge oder die Ladezeit.

Es lohnt sich übrigens, sich Dashboards im Google Lookerstudio anzulegen, um den Funnel übersichtlich darzustellen und so die wichtigsten KPIs immer im Blick zu haben. Dein Funnel könnte bspw. wie folgt aussehen:

- Umsatz und Conversions

- definierte Micro Conversions

- Einstiege und Seitenaufrufe

- Nutzerdaten wie Verweildauer und Absprungrate

- Klicks, Impressionen und CTR

- Sichtbarkeit und Rankingplatzierung

SEO-Tools für den täglichen Gebrauch

Solltest Du auf der Suche nach einem SEO-Tool sein, dann lohnt sich ein Blick in unseren SEO-Tool-Vergleich.

Um Deine Rankingveränderung der einzelnen Keywords zu beobachten und entsprechend zu reagieren, lohnt es sich ein Keyword Monitoring Tool zu nutzen.

Wer sich aktuell mit Linkaufbau beschäftigt, kann sich auch mal den Vergleich der Backlink-Checker anschauen.

Werde Teil der OMT-Community

Diesen Artikel bewerten

Mario Jung

SEO Seminare

Aktuelle Jobs im SEO